Kafka核心概念解析:消息系统基础与组件详解

Kafka核心概念:消息系统基础与核心组件解析

一、消息系统基础

发布-订阅模型 vs 消息队列

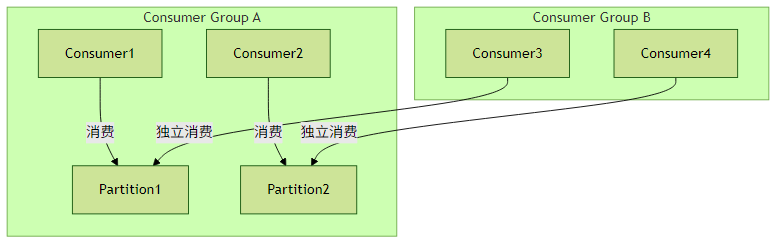

Kafka同时支持两种消息传递模式:

消息队列模式(点对点):

- 消息被消费后即从队列删除

适用于任务分发场景

// 消费者组示例:同组内竞争消费 props.put("group.id", "order-processors");

发布-订阅模式:

- 消息广播给所有订阅者

适用于事件通知场景

// 不同消费者组独立消费 props.put("group.id", "inventory-service");

实践建议:日志收集适合发布订阅,订单处理适合队列模式。通过消费者组机制灵活切换。

消息(Record)结构

每条Kafka消息包含三个核心要素:

| 字段 | 说明 | 示例值 |

|---|---|---|

| Key | 可选,用于分区路由 | "user123" (String) |

| Value | 实际消息内容(支持二进制) | "login success" (JSON) |

| Timestamp | 事件时间或消息入队时间 | 1625097600000 (Long) |

// 生产者构造消息示例

ProducerRecord<String, String> record = new ProducerRecord<>(

"user-events", // topic

"user123", // key

"{\"action\":\"login\"}" // value

);实践建议:合理设计Key保证相同业务实体的消息进入同一分区,维持顺序性。

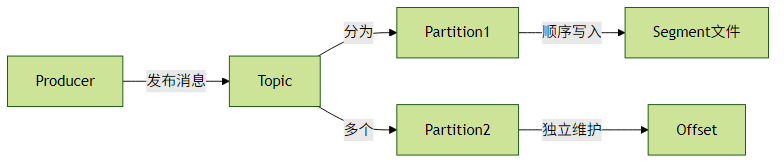

消息持久化与顺序性

Kafka通过以下机制保证可靠性:

- 持久化:消息写入磁盘并复制到多个Broker

- 顺序性:单个分区内消息严格有序(跨分区不保证)

实践建议:需要强顺序的业务(如订单状态变更)应使用相同Key确保路由到同一分区。

二、核心组件详解

Topic与Partition

| 概念 | 特性说明 |

|---|---|

| Topic | 逻辑消息分类,生产者和消费者的对接点 |

| Partition | 物理分片,每个分区都是有序不可变的消息队列 |

| Replication | 每个分区配置副本数(建议≥3),提高容错能力 |

分区策略示例:

// 自定义分区器(按业务键哈希)

public class OrderPartitioner implements Partitioner {

@Override

public int partition(String topic, Object key, byte[] keyBytes,

Object value, byte[] valueBytes, Cluster cluster) {

return Math.abs(key.hashCode()) % cluster.partitionCountForTopic(topic);

}

}Producer与Consumer

生产者关键行为:

Properties props = new Properties();

props.put("bootstrap.servers", "kafka1:9092,kafka2:9092");

props.put("acks", "all"); // 消息确认级别

props.put("retries", 3); // 失败重试

Producer<String, String> producer = new KafkaProducer<>(props);消费者关键配置:

props.put("enable.auto.commit", "false"); // 关闭自动提交

props.put("isolation.level", "read_committed"); // 事务消息隔离级别

Consumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList("topic1"));Consumer Group机制

黄金法则:分区数 ≥ 消费者组内消费者数量,否则会有消费者闲置

三、最佳实践指南

分区设计:

- 单个分区吞吐约10MB/s

- 分区数 = 目标吞吐 / 单分区吞吐

Offset管理:

// 手动提交Offset(推荐精确控制) while (true) { ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100)); for (ConsumerRecord<String, String> record : records) { processRecord(record); consumer.commitSync(Collections.singletonMap( new TopicPartition(record.topic(), record.partition()), new OffsetAndMetadata(record.offset() + 1))); } }监控关键指标:

- 生产/消费延迟

- 消费者Lag(未处理消息数)

- Broker磁盘使用率

通过深入理解这些核心概念,您已经掌握了Kafka最基础也是最重要的设计原理。建议在开发环境中创建测试Topic,实践不同分区和消费者组的组合效果。