Kafka运维监控实战:部署调优与故障排查指南

Kafka运维与监控实战指南:从部署调优到故障排查

作为分布式消息系统的核心组件,Kafka的运维监控质量直接影响系统稳定性。本文将深入讲解生产环境中Kafka集群的部署配置、监控指标和常见故障处理方案。

一、部署与配置优化

1. Broker关键参数配置

# 数据存储目录(建议SSD,多目录用逗号分隔)

log.dirs=/data1/kafka,/data2/kafka

# 默认分区数(根据业务预估设置)

num.partitions=6

# 网络线程数(通常等于CPU核心数)

num.network.threads=8

# IO线程数(建议2-3倍CPU核心数)

num.io.threads=16

# Socket缓冲区大小(根据网络调整)

socket.send.buffer.bytes=1024000

socket.receive.buffer.bytes=1024000实践建议:

- 生产环境至少配置3个Broker节点

log.dirs使用多块物理磁盘提升IO并行度- 分区数设置需考虑消费者并行处理能力

2. Topic配置策略

# 创建Topic时指定参数示例

bin/kafka-topics.sh --create \

--topic order_events \

--partitions 12 \

--replication-factor 3 \

--config retention.ms=172800000 \ # 保留2天

--config segment.bytes=1073741824 # 分段文件1GB关键参数说明:

replication.factor:生产环境建议≥3retention.ms:根据数据重要性设置(默认7天)segment.bytes:影响日志分段滚动频率

3. JVM调优指南

# 示例JVM参数(Kafka 3.0+)

export KAFKA_HEAP_OPTS="-Xms8g -Xmx8g"

export KAFKA_JVM_PERFORMANCE_OPTS="

-server

-XX:+UseG1GC

-XX:MaxGCPauseMillis=20

-XX:InitiatingHeapOccupancyPercent=35

-XX:+ExplicitGCInvokesConcurrent

-Djava.awt.headless=true"调优原则:

- 堆内存不超过物理内存的50%

- G1GC适合大内存场景(>8GB)

- 避免频繁Full GC(观察

jstat -gcutil)

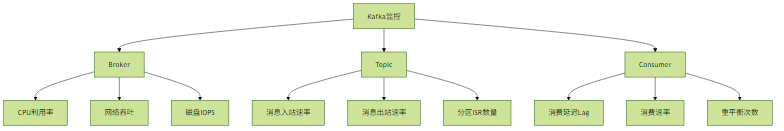

二、监控指标体系

1. 核心监控指标

关键指标阈值:

- 分区Leader倾斜:>20%差异需关注

- 消费Lag:>1000需告警

- 磁盘使用率:>75%需扩容

2. 监控工具集成

Prometheus配置示例:

scrape_configs:

- job_name: 'kafka'

static_configs:

- targets: ['kafka1:7071', 'kafka2:7071']

metrics_path: '/metrics'Grafana看板要点:

- Broker级:CPU/内存/网络/磁盘

- Topic级:生产消费速率/消息大小

- Consumer级:Lag/处理延迟

三、典型故障处理

1. 副本不同步问题

现象:

- ISR列表频繁变化

- Follower副本落后Leader

解决方案:

# 检查副本状态

bin/kafka-topics.sh --describe --topic my_topic

# 可能处理步骤

1. 检查网络延迟(ping/traceroute)

2. 增加replica.lag.time.max.ms(默认30s)

3. 重启问题Broker2. 消费延迟高

排查路径:

确认是特定Consumer Group问题

bin/kafka-consumer-groups.sh --describe --group my_group- 检查消费者处理逻辑(线程阻塞/GC停顿)

- 评估是否需要增加分区或消费者实例

3. 磁盘I/O瓶颈

优化方案:

- 使用

iostat -x 1确认磁盘利用率 调整刷盘策略:

# 异步刷盘(性能优先) log.flush.interval.messages=10000 log.flush.interval.ms=1000 # 控制fsync频率 log.flush.scheduler.interval.ms=3000

最佳实践总结

- 容量规划:提前预估峰值流量,预留30%资源缓冲

- 配置标准化:使用CM工具(Ansible/Puppet)管理配置

- 变更管理:每次只修改一个参数并观察效果

- 灾备演练:定期模拟Broker宕机测试高可用性

通过系统化的监控和科学的参数调优,可以构建出稳定高效的Kafka消息平台。建议将关键指标纳入统一监控平台,并建立分级告警机制。