Kafka客户端开发指南:Producer与Consumer实战解析

Kafka客户端开发深度解析:Producer与Consumer实战指南

一、Producer API核心机制

1.1 同步与异步发送模式

同步发送会阻塞当前线程直到收到服务器确认,适合对可靠性要求高的场景:

// 同步发送示例

ProducerRecord<String, String> record = new ProducerRecord<>("test-topic", "key", "value");

RecordMetadata metadata = producer.send(record).get(); // 阻塞等待

System.out.println("消息发送到分区 " + metadata.partition());异步发送通过回调机制实现非阻塞:

// 异步发送示例

producer.send(record, (metadata, exception) -> {

if (exception != null) {

exception.printStackTrace();

} else {

System.out.println("异步确认: " + metadata.offset());

}

});实践建议:

- 对延迟敏感场景使用异步发送

- 同步发送时设置合理超时(

request.timeout.ms) - 异步回调中必须处理异常

1.2 自定义分区策略

默认分区策略(轮询/Key哈希)可通过实现Partitioner接口扩展:

public class CustomPartitioner implements Partitioner {

@Override

public int partition(String topic, Object key, byte[] keyBytes,

Object value, byte[] valueBytes, Cluster cluster) {

List<PartitionInfo> partitions = cluster.partitionsForTopic(topic);

// 自定义逻辑示例:优先选择空闲分区

return selectLeastLoadedPartition(partitions);

}

// 需实现其他必要方法

}配置方式:

partitioner.class=com.your.package.CustomPartitioner实践建议:

- 确保分区逻辑的均匀性

- 避免频繁计算导致性能下降

- 分区变化时需处理重新映射

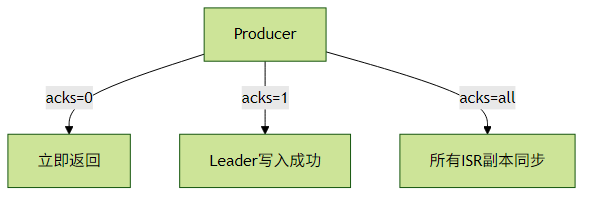

1.3 消息确认机制(acks)

| 配置值 | 可靠性 | 性能 | 适用场景 |

|---|---|---|---|

| acks=0 | 最低 | 最高 | 日志收集等可容忍丢失场景 |

| acks=1 | 中等 | 中等 | 默认配置,Leader写入即确认 |

| acks=all | 最高 | 最低 | 金融交易等关键业务 |

关键参数组合:

acks=all

retries=3

enable.idempotence=true # 启用幂等性二、Consumer API高级特性

2.1 Offset提交策略

手动提交对比:

| 方法 | 可靠性 | 性能 | 可能问题 |

|---|---|---|---|

| commitSync() | 高 | 低 | 阻塞调用 |

| commitAsync() | 中 | 高 | 可能丢失提交 |

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

processRecord(record);

}

// 异步提交+同步回退组合模式

consumer.commitAsync((offsets, exception) -> {

if (exception != null) {

consumer.commitSync(); // 异步失败时同步提交

}

});

}实践建议:

- 推荐使用异步提交+同步回退的组合模式

- 提交频率需平衡性能与重复消费风险

- 注意处理

CommitFailedException

2.2 再平衡监听器

实现ConsumerRebalanceListener处理分区变化:

consumer.subscribe(Collections.singletonList("topic"), new ConsumerRebalanceListener() {

@Override

public void onPartitionsRevoked(Collection<TopicPartition> partitions) {

// 分区被回收前提交偏移量

commitOffsets();

}

@Override

public void onPartitionsAssigned(Collection<TopicPartition> partitions) {

// 新分区分配后初始化状态

initializeState();

}

});再平衡触发场景:

- 消费者加入/离开组

- Topic分区数变化

- 心跳超时(

session.timeout.ms)

2.3 消费者拦截器

实现ConsumerInterceptor接口进行消息预处理:

public class MetricInterceptor<K, V> implements ConsumerInterceptor<K, V> {

private MetricsCollector collector;

@Override

public ConsumerRecords<K, V> onConsume(ConsumerRecords<K, V> records) {

collector.recordConsumed(records.count());

return records; // 可修改或过滤记录

}

@Override

public void onCommit(Map<TopicPartition, OffsetAndMetadata> offsets) {

collector.recordCommit(offsets);

}

}三、Kafka Streams开发模式

3.1 DSL vs Processor API

DSL示例(推荐大多数场景):

StreamsBuilder builder = new StreamsBuilder();

KStream<String, String> stream = builder.stream("input-topic");

stream.filter((k, v) -> v != null)

.mapValues(v -> v.toUpperCase())

.to("output-topic");Processor API(需要精细控制时使用):

Topology topology = new Topology();

topology.addSource("Source", "input-topic")

.addProcessor("Process", () -> new CustomProcessor(), "Source")

.addSink("Sink", "output-topic", "Process");3.2 State Store实战

// 创建状态存储

StoreBuilder<KeyValueStore<String, Long>> storeBuilder =

Stores.keyValueStoreBuilder(

Stores.persistentKeyValueStore("count-store"),

Serdes.String(),

Serdes.Long()

);

// 在拓扑中使用

builder.addStateStore(storeBuilder);

builder.stream("input").transform(() -> new CounterTransformer(), "count-store");交互式查询:

ReadOnlyKeyValueStore<String, Long> store =

streams.store("count-store", QueryableStoreTypes.keyValueStore());

store.get("key"); // 实时查询3.3 时间语义处理

// 使用事件时间

StreamsConfig config = new StreamsConfig(props);

config.put(StreamsConfig.DEFAULT_TIMESTAMP_EXTRACTOR_CLASS_CONFIG,

WallclockTimestampExtractor.class);

// 时间窗口处理

KStream<String, String> stream = builder.stream("input");

stream.groupByKey()

.windowedBy(TimeWindows.of(Duration.ofMinutes(5)))

.count()

.toStream()

.to("output");四、最佳实践总结

Producer调优:

- 合理设置

batch.size和linger.ms提升吞吐 - 监控

record-error-rate指标 - 关键业务启用

idempotence=true

- 合理设置

Consumer注意事项:

- 避免单消费者处理过多分区

- 监控

consumer-lag指标 - 合理设置

max.poll.records防止处理超时

Streams开发要点:

- 为状态存储配置合理的

retention.ms - 注意

cache.max.bytes.buffering对延迟的影响 - 使用

kafka-streams-application-reset工具进行测试重置

- 为状态存储配置合理的

通过深入理解这些客户端开发机制,可以构建出高性能、高可靠的Kafka应用程序。建议结合具体业务场景选择合适的API和配置参数。