Kafka连接器与系统集成深度指南

Kafka生态集成:连接器与系统集成深度解析

Kafka作为分布式流平台的核心价值不仅在于其自身的高吞吐量消息处理能力,更在于其强大的生态集成能力。本文将深入探讨Kafka Connect连接器框架以及与其他大数据系统的集成模式。

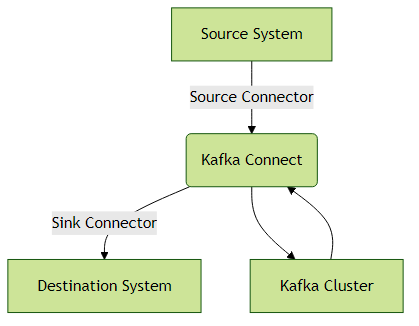

一、Kafka Connect:数据桥梁框架

1.1 核心架构与运行模式

Kafka Connect是专为Kafka与其他系统之间可靠数据传输设计的框架,其架构设计具有高度可扩展性:

单机模式适合开发测试:

bin/connect-standalone.sh config/connect-standalone.properties connector1.properties分布式模式具备高可用特性:

bin/connect-distributed.sh config/connect-distributed.properties关键差异:

| 特性 | 单机模式 | 分布式模式 |

|---|---|---|

| 高可用 | 无 | 支持多节点 |

| 负载均衡 | 无 | 自动分区分配 |

| 配置管理 | 文件配置 | REST API |

| 适用场景 | 开发测试 | 生产环境 |

1.2 常用连接器实践

JDBC Source连接器配置示例:

name=mysql-source

connector.class=io.confluent.connect.jdbc.JdbcSourceConnector

tasks.max=3

connection.url=jdbc:mysql://mysql:3306/inventory

connection.user=user

connection.password=pass

table.whitelist=customers

mode=incrementing

incrementing.column.name=id

topic.prefix=mysql-Elasticsearch Sink连接器配置:

name=elastic-sink

connector.class=io.confluent.connect.elasticsearch.ElasticsearchSinkConnector

tasks.max=2

topics=logs

connection.url=http://elasticsearch:9200

type.name=_doc

key.ignore=true

schema.ignore=true性能调优建议:

- 调整

tasks.max实现并行处理 - 合理设置

batch.size(默认2000) - 对于高吞吐场景启用压缩(

compression.type=gzip)

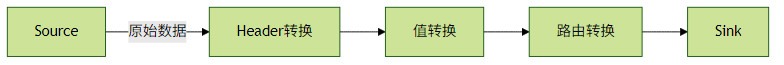

二、高级特性:转换与容错

2.1 数据转换(Transformations)

Kafka Connect支持在数据传输过程中进行实时转换:

常用转换示例:

transforms=InsertField,ReplaceField

transforms.InsertField.type=org.apache.kafka.connect.transforms.InsertField$Value

transforms.InsertField.static.field=data_source

transforms.InsertField.static.value=mysql

transforms.ReplaceField.type=org.apache.kafka.connect.transforms.ReplaceField$Value

transforms.ReplaceField.blacklist=credit_card2.2 容错机制

死信队列(DLQ)配置:

errors.tolerance=all

errors.deadletterqueue.topic.name=dlq-topic

errors.deadletterqueue.context.headers.enable=true实践建议:

- 监控DLQ主题的消息堆积

对于关键数据实现重试逻辑:

retry.backoff.ms=1000 max.retries=5

三、与流处理系统集成

3.1 Flink集成模式

// Flink消费Kafka示例

FlinkKafkaConsumer<String> consumer = new FlinkKafkaConsumer<>(

"input-topic",

new SimpleStringSchema(),

kafkaProps);

consumer.setStartFromLatest();

DataStream<String> stream = env.addSource(consumer);Exactly-Once实现:

// 启用检查点和两阶段提交

env.enableCheckpointing(5000);

kafkaProps.setProperty("isolation.level", "read_committed");3.2 Spark Streaming集成

val kafkaParams = Map(

"bootstrap.servers" -> "kafka:9092",

"key.deserializer" -> classOf[StringDeserializer],

"value.deserializer" -> classOf[StringDeserializer],

"group.id" -> "spark-group"

)

val stream = KafkaUtils.createDirectStream[String, String](

streamingContext,

LocationStrategies.PreferConsistent,

ConsumerStrategies.Subscribe[String, String](Set("topic"), kafkaParams)

)性能优化点:

- 调整

maxRatePerPartition控制消费速度 - 使用

foreachRDD实现精细控制

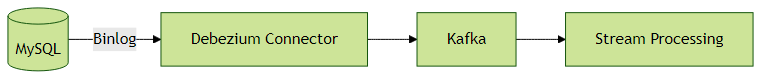

四、CDC与数据库集成

4.1 Debezium实战

Debezium作为CDC工具典型架构:

MySQL源配置示例:

name=mysql-inventory-connector

connector.class=io.debezium.connector.mysql.MySqlConnector

database.hostname=mysql

database.port=3306

database.user=debezium

database.password=dbz

database.server.id=184054

database.server.name=fullfillment

database.include.list=inventory

table.include.list=inventory.orders

database.history.kafka.bootstrap.servers=kafka:9092

database.history.kafka.topic=schema-changes.inventory处理逻辑表问题:

transforms=unwrap

transforms.unwrap.type=io.debezium.transforms.ExtractNewRecordState

transforms.unwrap.drop.tombstones=true五、跨集群数据同步

5.1 MirrorMaker 2.0

# mm2.properties

clusters=primary, secondary

primary.bootstrap.servers=kafka1:9092

secondary.bootstrap.servers=kafka2:9092

tasks.max=3

replication.factor=3

checkpoints.topic.replication.factor=1

heartbeats.topic.replication.factor=1

offset-syncs.topic.replication.factor=1

offset.storage.replication.factor=1

status.storage.replication.factor=1

config.storage.replication.factor=1

primary->secondary.enabled=true

primary->secondary.topics=.*关键配置项:

sync.topic.configs.enabled=true同步主题配置sync.topic.acls.enabled=true同步ACL权限refresh.topics.interval.seconds=600主题发现间隔

最佳实践总结

连接器管理:

- 使用Confluent Hub管理连接器生命周期

- 为每个连接器分配独立的消费者组

监控指标:

# 关键Connect指标 connect-task-metrics/batch-size-avg connect-task-metrics/offset-commit-completion-rate connect-task-metrics/poll-batch-avg-time-ms安全配置:

# SSL配置示例 ssl.truststore.location=/path/to/truststore.jks ssl.truststore.password=password ssl.keystore.location=/path/to/keystore.jks ssl.keystore.password=password ssl.key.password=password资源隔离:

- 关键业务连接器使用独立Worker集群

- 为不同SLA的任务配置独立的Connect集群

通过合理利用Kafka的生态集成能力,可以构建起完整的数据流通管道,实现从数据源到处理系统的端到端实时数据流。