Kafka安全防护:认证授权与审计全指南

Kafka安全与权限管理:从认证到审计的全方位防护

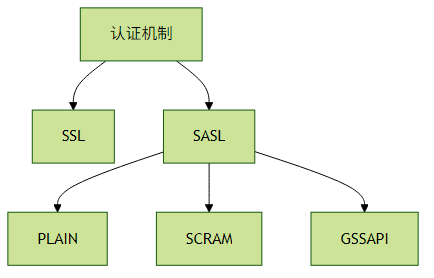

一、认证机制:构建安全第一道防线

1. SSL/SASL认证体系

Kafka提供两种主要认证方式:

SSL认证(端口通常为9093):

# broker配置

listeners=SSL://:9093

ssl.keystore.location=/path/to/kafka.server.keystore.jks

ssl.keystore.password=keystore_password

ssl.key.password=key_password

ssl.truststore.location=/path/to/kafka.server.truststore.jks

ssl.truststore.password=truststore_passwordSASL认证类型对比:

| 类型 | 安全性 | 适用场景 | 特点 |

|---|---|---|---|

| PLAIN | 低 | 测试环境 | 明文传输密码 |

| SCRAM | 中高 | 生产环境 | 支持密码轮换,盐值加密 |

| GSSAPI | 高 | 企业级Kerberos环境 | 需要部署KDC |

2. 双向认证(mTLS)实战

双向认证配置示例:

# broker端

ssl.client.auth=required

# 客户端配置

security.protocol=SSL

ssl.truststore.location=/path/to/client.truststore.jks

ssl.keystore.location=/path/to/client.keystore.jks实践建议:

- 生产环境禁用PLAIN机制

- SCRAM应设置至少4096次迭代

- 证书有效期不超过1年并建立轮换机制

使用工具生成SAN证书:

keytool -genkey -alias kafka -keyalg RSA -keystore server.keystore.jks \ -ext SAN=DNS:broker1.example.com,IP:192.168.1.1

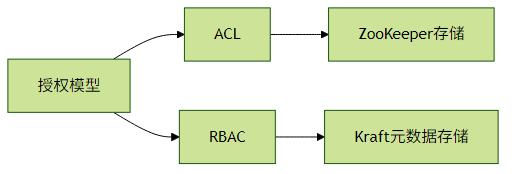

二、授权控制:精细化权限管理

1. ACL与RBAC对比

ACL基础命令:

# 创建用户权限

kafka-acls --authorizer-properties zookeeper.connect=localhost:2181 \

--add --allow-principal User:alice \

--operation Read --topic test-topic

# 查看权限

kafka-acls --list --topic test-topicRBAC操作(Kraft模式):

bin/kafka-configs.sh --bootstrap-server localhost:9092 \

--entity-type users --entity-name alice --alter \

--add-config 'SCRAM-SHA-512=[password=alice-secret]'2. 权限粒度控制矩阵

| 资源类型 | 操作权限 | 适用场景 |

|---|---|---|

| Topic | Create/Delete/Describe | 运维管理 |

| Group | Read/Describe/Delete | 消费者组管理 |

| Cluster | Alter/Create/Describe | 集群级操作 |

| TransactionalID | Write/Describe | 事务控制 |

最佳实践:

- 遵循最小权限原则

- 对生产环境Topic设置

DENY ALL默认策略 使用前缀匹配批量授权:

kafka-acls --add --allow-principal User:producer \ --producer --topic 'projectx.*'

三、加密与审计:数据全生命周期保护

1. 传输层加密配置

# server.properties

ssl.protocol=TLSv1.3

ssl.cipher.suites=TLS_AES_256_GCM_SHA384

ssl.endpoint.identification.algorithm=HTTPS2. 审计日志配置

# 启用审计日志

authorizer.class.name=kafka.security.authorizer.AclAuthorizer

super.users=User:admin

kafka.authorizer.logger=INFO审计日志示例输出:

[2023-07-20 15:30:45] User:alice ALLOWED Read topic=test-topic

[2023-07-20 15:31:02] User:bob DENIED Write topic=sensitive-data合规性建议:

- 使用ELK或Splunk集中收集审计日志

- 设置日志保留策略(至少90天)

定期进行权限审计检查:

kafka-acls --list --zk-tls-config-file zk.properties > acl_report_$(date +%F).txt

四、常见问题排查指南

认证失败:

- 检查JAAS配置路径:

-Djava.security.auth.login.config=/path/to/jaas.conf - 验证Kerberos票据:

klist

- 检查JAAS配置路径:

权限不足:

# 检查有效权限 kafka-acls --list --principal User:aliceTLS握手失败:

openssl s_client -connect broker:9093 -showcerts审计日志缺失:

确认log4j.properties包含:log4j.logger.kafka.authorizer.logger=INFO, authorizerAppender

五、安全加固检查清单

- [ ] 禁用PLAIN和匿名访问

- [ ] 启用TLS1.2+并禁用弱密码套件

- [ ] 设置

ssl.client.auth=required实现双向认证 - [ ] 定期轮换SCRAM密码和SSL证书

- [ ] 配置网络ACL限制9093端口访问

- [ ] 启用审计日志并集中存储

- [ ] 对超级用户启用双因素认证

通过以上多层次安全防护,可构建符合金融级安全要求的Kafka集群。建议每季度进行安全评估,及时跟进CVE漏洞修复。