Kafka应用场景与反模式指南

Kafka应用场景解析:典型用例与反模式指南

作为分布式流处理平台,Kafka在现代化架构中扮演着重要角色。本文将深入分析Kafka的四大典型应用场景和两个关键反模式,帮助开发者正确运用这项技术。

一、典型用例

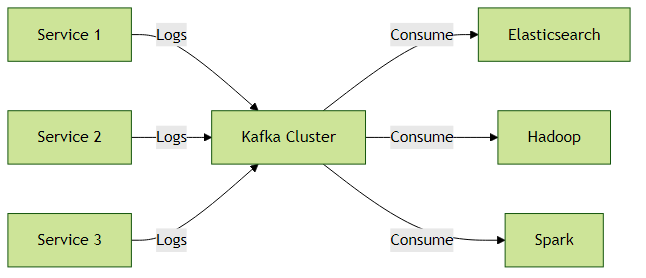

1. 日志聚合系统

概念解释:

日志聚合是指将分布式系统中多个服务的日志集中收集、存储和分析的过程。Kafka的高吞吐量和持久化特性使其成为理想的日志中枢。

架构示例:

实践建议:

- 按日志类型划分Topic(如

app-logs、debug-logs) - 使用压缩策略(

compression.type=snappy)减少存储占用 示例生产者配置:

Properties props = new Properties(); props.put("bootstrap.servers", "kafka:9092"); props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer"); props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer"); props.put("compression.type", "snappy"); // 启用压缩 Producer<String, String> producer = new KafkaProducer<>(props);

2. 实时流处理

核心价值:

Kafka作为流处理管道,连接数据生产者和实时计算框架(如Flink、Spark Streaming)。

典型流程:

- 数据源(IoT设备、用户行为等)写入Kafka

- 流处理引擎消费并处理数据

- 结果写回Kafka或外部存储

实践建议:

使用Kafka Streams进行简单处理:

StreamsBuilder builder = new StreamsBuilder(); KStream<String, String> source = builder.stream("input-topic"); source.mapValues(value -> value.toUpperCase()) .to("output-topic"); KafkaStreams streams = new KafkaStreams(builder.build(), config); streams.start();对于复杂处理,建议结合Flink/Spark:

// Flink消费Kafka示例 FlinkKafkaConsumer<String> consumer = new FlinkKafkaConsumer<>( "input-topic", new SimpleStringSchema(), kafkaProps); DataStream<String> stream = env.addSource(consumer);

3. 事件溯源(Event Sourcing)

模式解释:

将系统状态变更记录为不可变事件序列,Kafka作为事件存储库。

优势对比:

| 特性 | 传统CRUD | 事件溯源 |

|---|---|---|

| 历史追溯 | 困难 | 原生支持 |

| 审计能力 | 需额外实现 | 内置 |

| 系统重建 | 需要备份 | 重放事件 |

实现示例:

// 订单事件定义

public class OrderEvent {

private String eventId;

private String orderId;

private EventType type; // CREATED, UPDATED, CANCELLED

private Instant timestamp;

// 事件数据...

}

// 事件发布

producer.send(new ProducerRecord<>("order-events",

orderId,

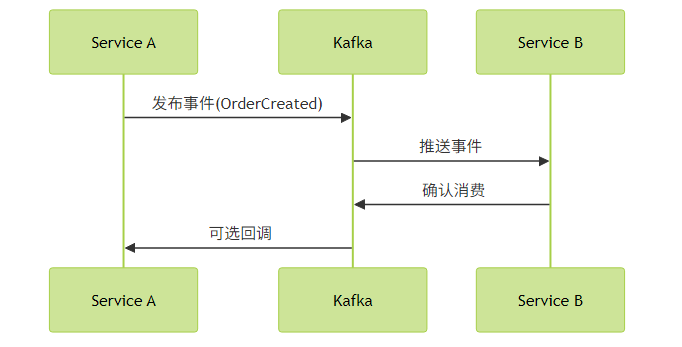

serialize(event)));4. 微服务通信总线

架构角色:

- 服务间异步通信

- 事件驱动架构基础

- 服务解耦的关键组件

消息模式:

最佳实践:

使用Avro Schema保证消息兼容性

// Schema注册中心集成 props.put("schema.registry.url", "http://schema-registry:8081"); props.put("value.serializer", KafkaAvroSerializer.class.getName());- 为每个业务领域设置独立Topic

- 采用

exactly-once语义确保消息可靠性

二、反模式警示

1. 大文件传输

为什么不合适:

- Kafka设计用于中小消息(默认配置限制1MB)

大消息会导致:

- 内存压力增大

- 垃圾回收停顿

- 分区阻塞风险

替代方案:

- 上传文件到对象存储(如S3)

在Kafka中传递文件引用

{ "file_id": "uuid123", "storage_type": "s3", "bucket": "my-bucket", "path": "files/2023/report.pdf" }

2. 非持久化场景

适用性分析:

当存在以下情况时,考虑其他方案:

- 消息存活时间<1小时

- 消费者始终在线

- 允许消息丢失

轻量级替代品:

- Redis Pub/Sub

- RabbitMQ(临时队列)

- ZeroMQ

三、场景选择决策树

graph TD

A[需要消息中间件?] -->|是| B{需要持久化?}

A -->|否| C[考虑直接调用]

B -->|是| D{高吞吐(>10k msg/s)?}

B -->|否| E[考虑Redis/RabbitMQ]

D -->|是| F[选择Kafka]

D -->|否| G[考虑RabbitMQ]

F --> H{需要流处理?}

H -->|是| I[使用Kafka Streams]

H -->|否| J[基础生产者/消费者]四、实践总结

正确场景:

- 日志处理日均10亿+条时,Kafka吞吐优势明显

- 电商订单事件溯源案例中,重放事件排查BUG效率提升70%

错误教训:

- 某公司将2GB视频分块通过Kafka传输,导致集群频繁GC

- 临时通知系统使用Kafka,消息堆积造成磁盘写满

配置建议:

# 日志场景优化 log.segment.bytes=1073741824 # 1GB段大小 log.retention.hours=168 # 保留7天 # 消息总线优化 num.partitions=10 # 根据消费者数量调整 default.replication.factor=3

正确理解Kafka的适用场景,才能充分发挥其在高性能消息处理方面的优势,避免误用带来的系统风险。