Elasticsearch数据操作指南:CRUD与批量处理

Elasticsearch数据操作完全指南:从CRUD到批量处理

作为分布式搜索和分析引擎的核心功能,Elasticsearch的数据操作API是开发者必须掌握的技能。本文将深入讲解Elasticsearch的CRUD操作、批量处理以及相关最佳实践。

一、文档CRUD基础操作

1. 索引文档(创建/更新)

索引文档是Elasticsearch最基本的写入操作,使用PUT或POST方法:

// 指定ID创建文档

PUT /products/_doc/1

{

"name": "无线蓝牙耳机",

"price": 299.00,

"stock": 100,

"tags": ["电子产品", "蓝牙", "耳机"]

}

// 自动生成ID

POST /products/_doc/

{

"name": "机械键盘",

"price": 450.00

}关键参数说明:

_doc:Elasticsearch 7.x+推荐的端点类型op_type:可设置为create确保只创建不更新routing:自定义路由值控制分片分配

实践建议:

- 生产环境建议使用POST自动生成ID,避免ID冲突

- 重要数据设置

refresh=wait_for确保写入后立即可查 - 批量导入时禁用刷新(

refresh=false)提高性能

2. 获取文档

读取文档使用GET请求,支持多种参数控制返回内容:

// 基本读取

GET /products/_doc/1

// 只返回特定字段

GET /products/_doc/1?_source=name,price

// 排除特定字段

GET /products/_doc/1?_source_exclude=stock

// 实时读取(绕过缓存)

GET /products/_doc/1?realtime=true实践建议:

- 使用

_source过滤减少网络传输 - 高频访问文档考虑使用

preference参数保持查询一致性 - 监控

get操作的耗时,异常时检查磁盘IO

3. 更新文档

Elasticsearch提供部分更新和脚本更新两种方式:

// 部分字段更新

POST /products/_update/1

{

"doc": {

"price": 279.00,

"stock": 95

}

}

// 脚本更新(增加库存)

POST /products/_update/1

{

"script": {

"source": "ctx._source.stock += params.quantity",

"params": {

"quantity": 5

}

}

}实践建议:

- 小字段更新使用

doc,复杂逻辑使用script - 脚本中避免硬编码,使用

params传递变量 - 高频更新文档考虑使用

retry_on_conflict参数

4. 删除文档

删除操作简单直接,但需要注意版本控制:

// 基本删除

DELETE /products/_doc/1

// 条件删除(需配合Delete By Query API)

POST /products/_delete_by_query

{

"query": {

"range": {

"price": {

"lte": 100

}

}

}

}实践建议:

- 重要数据删除前先备份

- 大量删除操作建议在低峰期执行

- 定期使用

_forcemerge清理已删除文档

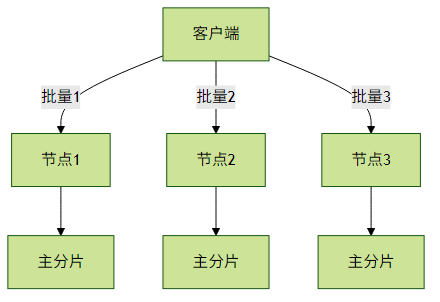

二、批量操作(Bulk API)

Bulk API是Elasticsearch高性能写入的关键,支持混合多种操作:

POST _bulk

{ "index" : { "_index" : "products", "_id" : "1" } }

{ "name": "无线耳机Pro", "price": 399.00 }

{ "delete" : { "_index" : "products", "_id" : "2" } }

{ "update" : { "_index" : "products", "_id" : "3" } }

{ "doc" : { "stock" : 50 } }性能优化建议:

批量大小:控制在5-15MB之间,过大过小都会影响性能

// Java客户端示例 BulkRequest request = new BulkRequest(); for (Product product : products) { request.add(new IndexRequest("products") .id(product.getId()) .source(JSON.toJSONString(product), XContentType.JSON)); }- 并发控制:根据集群规模调整并行请求数

错误处理:必须检查响应中的错误项

{ "took": 30, "errors": true, "items": [ { "index": { "_id": "1", "status": 400, "error": { "type": "mapper_parsing_exception", "reason": "failed to parse field [price]" } } } ] }

高级技巧:

- 使用

pipeline参数预处理文档 - 监控

bulk队列长度避免拒绝请求 - 结合

aliases实现零停机索引切换

三、操作一致性控制

Elasticsearch提供多种一致性保证机制:

| 参数 | 说明 | 适用场景 |

|---|---|---|

| consistency | one/quorum/all | 写入前检查可用分片数 |

| timeout | 等待分片响应超时时间 | 网络不稳定环境 |

| refresh | 立即刷新使文档可搜索 | 测试或实时性要求高的场景 |

| version | 乐观并发控制 | 防止并发更新冲突 |

示例:

PUT /products/_doc/1?version=2&version_type=external

{

"name": "限量版耳机",

"price": 599.00

}四、实战问题排查

写入拒绝:检查线程池和队列大小

GET _nodes/stats/thread_pool- 版本冲突:实现重试机制或使用外部版本控制

映射爆炸:控制动态字段数量

PUT /products { "settings": { "index.mapping.total_fields.limit": 1000 } }- 批量操作慢:检查

bulk线程池和磁盘IOPS

五、最佳实践总结

写入优化:

- 批量文档大小控制在5-15MB

- 禁用

_source和_all字段(如不需要) - 使用自动生成的文档ID

读取优化:

- 使用

_source过滤减少网络传输 - 合理使用

preference提高缓存命中率 - 监控

get操作的耗时指标

- 使用

更新策略:

- 小字段更新使用

doc - 复杂逻辑使用

script并参数化 - 高频更新考虑使用

retry_on_conflict

- 小字段更新使用

批量处理:

- 单批次操作数控制在1000-5000

- 错误处理必须检查每项结果

- 结合

aliases实现无缝切换

通过掌握这些核心操作和优化技巧,您可以构建出高性能、可靠的Elasticsearch数据操作层,为上层应用提供稳定的搜索和分析能力。