Elasticsearch集成实战:ELK Stack与多语言开发指南

Elasticsearch生态系统集成实战指南

一、ELK Stack深度集成

1. Logstash数据处理管道

Logstash作为ELK中的"L",是数据处理的关键枢纽。典型配置包含input、filter和output三大模块:

input {

file {

path => "/var/log/nginx/access.log"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

date {

match => [ "timestamp", "dd/MMM/yyyy:HH:mm:ss Z" ]

}

}

output {

elasticsearch {

hosts => ["http://localhost:9200"]

index => "nginx-%{+YYYY.MM.dd}"

}

}实践建议:

- 使用Grok Debugger工具调试日志解析模式

- 对于复杂数据处理,考虑添加mutate、geoip等过滤器

- 生产环境建议启用持久化队列(queue.type: persisted)

2. Kibana可视化实战

Kibana不仅提供可视化,更是Elasticsearch的数据探索门户。核心功能包括:

- Discover:原始数据探索

- Visualize:创建图表(柱状图、饼图、热图等)

- Dashboard:组合多个可视化

- Lens:拖拽式分析工具

示例时序数据分析:

{

"aggs": {

"requests_over_time": {

"date_histogram": {

"field": "@timestamp",

"calendar_interval": "1h"

}

}

}

}实践建议:

- 利用TSVB(Time Series Visual Builder)进行高级时序分析

- 保存常用查询为"Saved Objects"提高效率

- 对敏感数据设置基于角色的访问控制(RBAC)

3. Beats轻量级数据采集

Beats家族成员及典型应用场景:

| Beat类型 | 数据源 | 典型配置项 |

|---|---|---|

| Filebeat | 日志文件 | paths, exclude_files, multiline |

| Metricbeat | 系统/服务指标 | modules (system, mysql, etc.) |

| Packetbeat | 网络流量 | protocols, interfaces |

| Auditbeat | 审计日志 | auditd rules |

Filebeat配置示例:

filebeat.inputs:

- type: log

paths:

- /var/log/app/*.log

fields:

app: myapp

processors:

- drop_event.when.regexp.message: "^DEBUG"

output.elasticsearch:

hosts: ["es-node1:9200", "es-node2:9200"]

indices:

- index: "app-%{[fields.app]}-%{+yyyy.MM.dd}"实践建议:

- 合理使用processors减少不必要的数据传输

- 对于大规模部署,考虑通过Logstash中转处理

- 监控Beats自身资源使用情况

二、多语言客户端开发

1. Java High Level REST Client

Java客户端是与Elasticsearch交互的首选方式,示例CRUD操作:

// 创建客户端

RestHighLevelClient client = new RestHighLevelClient(

RestClient.builder(new HttpHost("localhost", 9200, "http")));

// 索引文档

IndexRequest request = new IndexRequest("posts")

.id("1")

.source("user", "kimchy",

"postDate", new Date(),

"message", "trying out Elasticsearch");

IndexResponse response = client.index(request, RequestOptions.DEFAULT);

// 搜索文档

SearchRequest searchRequest = new SearchRequest("posts");

SearchSourceBuilder sourceBuilder = new SearchSourceBuilder();

sourceBuilder.query(QueryBuilders.matchQuery("user", "kimchy"));

searchRequest.source(sourceBuilder);

SearchResponse searchResponse = client.search(searchRequest, RequestOptions.DEFAULT);实践建议:

- 确保客户端版本与Elasticsearch集群版本匹配

- 使用try-with-resources或正确关闭客户端

- 批量操作时合理设置批量大小(建议5-15MB)

2. Python客户端示例

Python客户端适合快速原型开发:

from elasticsearch import Elasticsearch

es = Elasticsearch(["http://localhost:9200"])

# 创建索引

es.indices.create(index="books", ignore=400)

# 批量索引

documents = [

{"_index": "books", "_id": 1, "title": "Python编程", "price": 59},

{"_index": "books", "_id": 2, "title": "Elasticsearch指南", "price": 79}

]

helpers.bulk(es, documents)

# 聚合查询

body = {

"aggs": {

"avg_price": {"avg": {"field": "price"}}

}

}

result = es.search(index="books", body=body)实践建议:

- 使用

elasticsearch-dsl进行更优雅的查询构建 - 异步场景考虑

aioelasticsearch - 生产环境配置重试机制和超时设置

3. Go客户端并发处理

Go客户端适合高并发场景:

client, err := elastic.NewClient(

elastic.SetURL("http://localhost:9200"),

elastic.SetSniff(false),

)

// 并发批量索引

var wg sync.WaitGroup

for i := 0; i < 10; i++ {

wg.Add(1)

go func(id int) {

defer wg.Done()

_, err := client.Index().

Index("products").

Id(strconv.Itoa(id)).

BodyJson(map[string]interface{}{

"name": fmt.Sprintf("Product %d", id),

"price": rand.Intn(100),

}).

Do(context.Background())

}(i)

}

wg.Wait()实践建议:

- 使用连接池提高性能

- 利用context实现超时控制

- 错误处理时检查

elastic.IsNotFound等特定错误

三、数据源集成方案

1. 数据库连接器配置

使用Logstash JDBC插件同步关系型数据:

input {

jdbc {

jdbc_driver_library => "/path/to/mysql-connector-java.jar"

jdbc_driver_class => "com.mysql.jdbc.Driver"

jdbc_connection_string => "jdbc:mysql://localhost:3306/mydb"

jdbc_user => "user"

jdbc_password => "password"

schedule => "* * * * *"

statement => "SELECT * FROM products WHERE updated_at > :sql_last_value"

tracking_column => "updated_at"

use_column_value => true

}

}

output {

elasticsearch {

document_id => "%{product_id}"

index => "products"

}

}实践建议:

- 增量同步使用

sql_last_value避免全量扫描 - 大表同步时考虑分页查询

- 设置合理的schedule避免源数据库压力过大

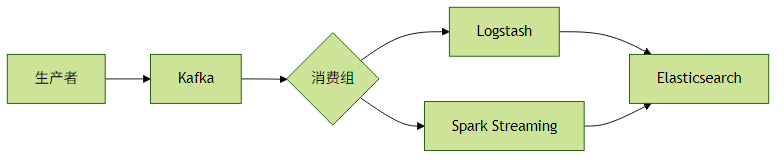

2. 消息队列集成模式

与Kafka集成的典型架构:

Logstash Kafka输入配置:

input {

kafka {

bootstrap_servers => "kafka1:9092,kafka2:9092"

topics => ["logs"]

codec => json

consumer_threads => 3

}

}实践建议:

- 根据消息量调整consumer_threads数量

- 处理失败时配置死信队列(DLQ)

- 监控消费者延迟(consumer lag)

3. 云服务集成策略

AWS S3集成示例(通过Filebeat):

filebeat.inputs:

- type: s3

queue_url: https://sqs.us-east-1.amazonaws.com/1234/myqueue

visibility_timeout: 300s

credential_profile_name: production

output.elasticsearch:

hosts: ["https://es-cluster:9200"]

pipeline: "s3_parsing"云服务集成方案对比:

| 服务商 | 服务名称 | 集成方式 | 适用场景 |

|---|---|---|---|

| AWS | S3/SQS/SNS | Filebeat/Lambda | 日志归档、事件驱动 |

| GCP | Pub/Sub | Logstash输入插件 | 实时消息处理 |

| Azure | Blob Storage | 函数触发器+ES客户端 | 存储后端数据分析 |

实践建议:

- 利用云服务商提供的原生连接器简化配置

- 跨区域传输考虑压缩和加密

- 监控云服务API调用配额和成本

四、性能优化与最佳实践

客户端优化:

- 批量操作使用Bulk API(建议批量大小5-15MB)

- 启用HTTP连接池并合理设置最大连接数

- 实现指数退避的重试策略

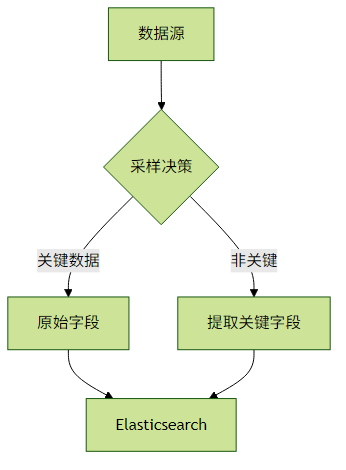

- 数据管道优化:

- 对非关键数据只提取必要字段

- 在进入Elasticsearch前进行数据采样

错误处理模式:

try { BulkResponse response = client.bulk(request, RequestOptions.DEFAULT); if (response.hasFailures()) { for (BulkItemResponse item : response.getItems()) { if (item.isFailed()) { log.error("Failed to index {}: {}", item.getId(), item.getFailureMessage()); // 实现重试或死信队列逻辑 } } } } catch (ElasticsearchStatusException e) { if (e.status() == RestStatus.TOO_MANY_REQUESTS) { // 处理429错误 } }

通过以上集成方案,Elasticsearch可以成为企业数据生态系统的核心分析引擎,实现从数据采集到洞察的全流程支持。