Elasticsearch核心概念解析:近实时与分布式架构

Elasticsearch核心概念与架构解析:近实时与分布式基础

一、近实时(NRT)机制解析

Elasticsearch的"近实时"(Near Real-Time)特性是其区别于传统数据库的重要特征,理解其实现原理对性能调优至关重要。

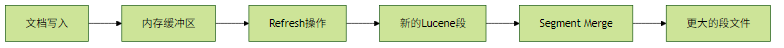

索引刷新(Refresh)与段合并(Segment Merge)

Refresh过程:

- 默认每1秒执行一次,可通过

index.refresh_interval调整 - 将内存缓冲区中的文档转化为可搜索的Lucene段

- 刷新后文档立即可见(但尚未持久化到磁盘)

示例:调整刷新间隔

PUT /my_index/_settings

{

"index.refresh_interval": "30s"

}段合并:

- 后台自动执行的小文件合并过程

- 减少段数量,提升查询性能

- 可能引发I/O和CPU资源消耗

实践建议:

- 写入密集型场景可适当增大刷新间隔

- 监控

segment.count和segment.memory指标 - 避免频繁强制刷新(

_refreshAPI)

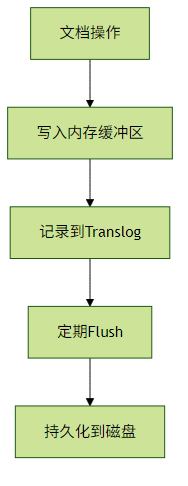

事务日志(Translog)的作用

关键特性:

- 每个分片拥有独立的Translog

- 默认每5秒同步到磁盘(

index.translog.sync_interval) - 提供崩溃恢复能力

配置示例:

PUT /my_index/_settings

{

"index.translog.durability": "async",

"index.translog.sync_interval": "10s"

}实践建议:

- 对数据安全性要求高的场景使用

"request"模式 - 大容量磁盘可适当增大

translog.flush_threshold_size - 定期监控

translog.operations和translog.size指标

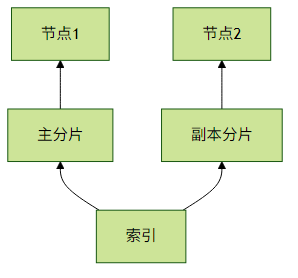

二、分布式基础架构

分片(Shard)与副本(Replica)机制

分片策略:

- 主分片数在创建索引时确定且不可修改

- 副本分片数可动态调整

- 分片大小建议控制在30-50GB

示例:创建带分片的索引

PUT /products

{

"settings": {

"number_of_shards": 5,

"number_of_replicas": 1

}

}实践建议:

- 根据数据量和查询负载确定分片数

- 热数据索引可增加副本提高查询吞吐

- 使用

_cat/shards?v监控分片状态

节点角色与职责

| 节点类型 | 职责 | 配置参数 |

|---|---|---|

| Master-eligible | 管理集群状态和元数据 | node.master: true |

| Data | 存储索引数据 | node.data: true |

| Ingest | 预处理文档 | node.ingest: true |

| Coordinating | 路由请求/聚合结果(默认所有节点) | 无专用参数 |

示例:专用协调节点配置

node.master: false

node.data: false

node.ingest: false实践建议:

- 生产环境至少配置3个Master节点

- 大数据集群分离协调节点和数据节点

- 监控

node_stats各角色资源使用情况

一致性模型解析

写入一致性级别:

one:主分片成功即可quorum:大多数分片副本成功(默认)all:全部分片副本成功

读一致性控制:

GET /products/_search?preference=_primary

{

"query": {...}

}实践建议:

- 关键数据写入使用

wait_for_active_shards参数 - 读操作可指定

preference控制路由 - 监控

cluster_state版本变化频率

三、总结与最佳实践

近实时调优:

- 根据业务需求平衡实时性和写入性能

- 监控

refresh_time和merge相关指标

分布式设计:

- 合理规划分片数量和节点角色

- 遵循"热-温-冷"架构设计原则

一致性选择:

- 非关键数据可降低一致性要求提升吞吐

- 金融类业务建议使用强一致性配置

通过深入理解这些核心机制,您将能够更好地设计Elasticsearch集群架构,并在性能与可靠性之间取得最佳平衡。