Elasticsearch故障排查:分片分配与熔断处理指南

Elasticsearch故障排查实战指南:从分片分配到熔断处理

作为分布式搜索和分析引擎,Elasticsearch在生产环境中常会遇到各种异常情况。本文将深入剖析两类典型问题——分片未分配和熔断器触发,并分享日志分析的最佳实践。

一、分片未分配(Unassigned Shards)深度解析

常见原因与诊断方法

分片未分配是Elasticsearch集群最常见的问题之一,可通过GET _cluster/allocation/explain API获取详细解释:

// 诊断命令示例

GET _cluster/allocation/explain

{

"index": "my_index",

"shard": 0,

"primary": true

}典型原因矩阵:

| 原因类型 | 特征表现 | 解决方案 |

|---|---|---|

| 节点容量不足 | disk watermark相关日志 | 扩容节点或清理磁盘空间 |

| 分片分配规则限制 | exclude._ip等属性设置 | 调整集群路由设置 |

| 索引配置错误 | index.routing.allocation设置 | 修正索引配置 |

| 节点重启未完成 | DELAYED状态 | 等待恢复或手动分配 |

| 副本数设置过高 | 集群节点数不足承载副本 | 调整index.number_of_replicas |

实战处理流程

检查集群健康状态:

GET _cluster/health?pretty重点关注

unassigned_shards数值查看未分配分片详情:

GET _cat/shards?v&h=index,shard,prirep,state,unassigned.reason&s=state强制分配分片(紧急情况):

POST _cluster/reroute { "commands": [{ "allocate_stale_primary": { "index": "my_index", "shard": 0, "node": "node1", "accept_data_loss": true } }] }

实践建议:对于生产集群,建议设置cluster.routing.allocation.disk.watermark.low: 85%和high: 90%的磁盘警戒线。

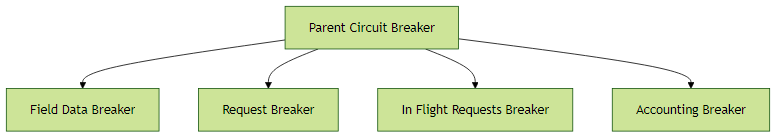

二、熔断器(Circuit Breaker)机制与处理

Elasticsearch的熔断器系统是防止JVM OOM的关键保护机制,主要包括:

各熔断器触发场景

Field Data熔断:

{ "error": { "reason": "[parent] Data too large, data for [<http_request>]..." } }处理方案:

- 优化映射:将不参与聚合的text字段设为

"fielddata": false - 增加JVM堆大小(不超过物理内存的50%)

- 优化映射:将不参与聚合的text字段设为

Request熔断:

{ "type": "circuit_breaking_exception", "reason": "[request] Data too large..." }处理方案:

- 分页查询:使用

search_after替代深度分页 - 限制聚合桶数量:

terms聚合中添加size参数

- 分页查询:使用

熔断器配置优化

# elasticsearch.yml 配置示例

indices.breaker.fielddata.limit: 40% # 默认为JVM堆的60%

indices.breaker.request.limit: 30% # 单个请求内存限制

indices.breaker.total.limit: 70% # 所有熔断器总限制实践建议:对于高负载集群,建议监控_nodes/stats/breaker接口,建立内存使用预警机制。

三、日志分析实战技巧

慢查询日志(Slow Log)分析

慢查询日志需要分别在索引设置中开启:

PUT /my_index/_settings

{

"index.search.slowlog.threshold.query.warn": "10s",

"index.search.slowlog.threshold.fetch.debug": "500ms"

}典型慢查询优化案例:

全文本搜索未使用索引:

{ "query": { "wildcard": { "message": "*error*" } } }优化方案:改用分词器处理的text字段进行搜索

深度分页性能问题:

{ "from": 10000, "size": 10 }优化方案:改用

search_after分页方式

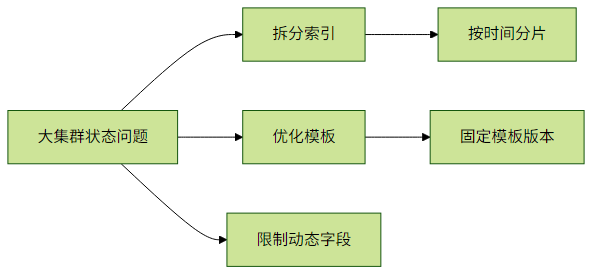

集群状态(Cluster State)诊断

集群状态过大(超过100MB)会导致管理操作变慢:

# 查看集群状态大小

GET _cluster/stats?human&filter_path=indices.completion.size_in_bytes优化策略:

- 清理不再使用的索引模板

- 拆分大集群为多个小集群(当节点数超过100时)

- 限制动态映射的字段数量

四、综合故障排查路线图

紧急处理:

- 检查集群健康状态(

_cluster/health) - 查看待处理任务(

_cluster/pending_tasks)

- 检查集群健康状态(

深度诊断:

- 分析热点线程(

_nodes/hot_threads) - 检查资源使用(

_nodes/stats)

- 分析热点线程(

长期优化:

- 建立性能基线

- 实施监控告警(如Elasticsearch Alerting)

关键指标监控清单:

jvm.mem.heap_used_percent> 75% 需要警惕thread_pool.search.rejected数值持续增长indices.query_cache.miss_count突然升高

通过系统化的故障排查方法,可以显著提高Elasticsearch集群的稳定性。建议定期进行故障演练,并建立完善的监控体系,将问题消灭在萌芽阶段。