Docker边缘计算实践:Alpine优化与IoT设备透传

Docker在边缘计算与IoT中的轻量级实践:Alpine优化与设备透传

引言:边缘计算对容器的特殊需求

边缘计算环境通常面临三大挑战:资源受限(如树莓派等设备)、设备多样性(需要访问各类硬件)和网络不稳定。Docker容器凭借其轻量化和标准化特性,成为边缘计算的理想载体。本文将重点介绍两个关键技术点:轻量级容器实现和设备透传方法。

一、轻量级容器实践

1. Alpine镜像深度优化

Alpine Linux以其小巧(基础镜像仅5MB)和安全(musl libc和busybox组合)著称,是边缘设备的首选基础镜像。

优化示例Dockerfile:

# 多阶段构建:编译阶段使用完整工具链

FROM golang:1.18 as builder

WORKDIR /app

COPY . .

RUN CGO_ENABLED=0 GOOS=linux go build -o edge-app

# 最终阶段使用Alpine

FROM alpine:3.16

RUN apk add --no-cache tzdata && \

cp /usr/share/zoneinfo/Asia/Shanghai /etc/localtime && \

echo "Asia/Shanghai" > /etc/timezone && \

apk del tzdata

WORKDIR /app

COPY --from=builder /app/edge-app .

USER nobody # 非root用户运行

CMD ["./edge-app"]关键优化点:

--no-cache:避免缓存占用空间- 时区配置后立即删除tzdata包

- 多阶段构建分离编译和运行环境

- 使用非root用户增强安全性

实践建议:

# 查看镜像层大小分析

docker history my-edge-image

# 使用dive工具分析镜像

docker run --rm -it \

-v /var/run/docker.sock:/var/run/docker.sock \

wagoodman/dive:latest my-edge-image2. 单进程容器设计模式

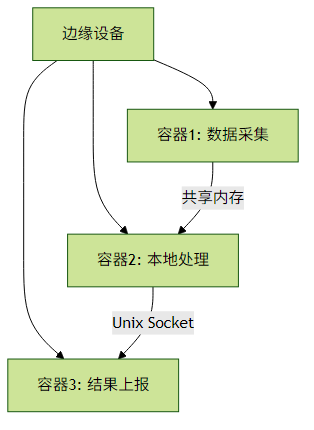

边缘设备资源有限,推荐采用"单进程容器"原则:

实现要点:

- 每个容器只运行一个主进程(PID 1)

进程间通信采用:

- 共享内存(

--ipc=shareable) - Unix Domain Socket(绑定挂载目录)

- 轻量级消息队列(如NATS)

- 共享内存(

异常处理实践:

# 使用--init参数处理僵尸进程

docker run --init alpine sh -c "your_script.sh"

# 健康检查配置

docker run --health-cmd="curl -f http://localhost/health" \

--health-interval=30s \

your-image二、设备透传实战

1. USB设备透传

典型场景:访问USB摄像头、传感器等

# 查看主机USB设备

lsusb

# 透传特定设备(以/dev/ttyUSB0为例)

docker run -it --rm \

--device=/dev/ttyUSB0 \

-e DEVICE=/dev/ttyUSB0 \

edge-app:latest

# 透传整个USB子系统(需谨慎)

docker run -it --rm \

--privileged \

-v /dev/bus/usb:/dev/bus/usb \

edge-app:latest权限管理技巧:

# 创建udev规则(/etc/udev/rules.d/99-mydevice.rules)

SUBSYSTEM=="usb", ATTR{idVendor}=="abcd", MODE="0666"

# 重载udev规则

sudo udevadm control --reload-rules2. GPU设备加速

NVIDIA GPU透传方案:

# 安装nvidia-container-toolkit

distribution=$(. /etc/os-release;echo $ID$VERSION_ID) \

&& curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add - \

&& curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt-get update && sudo apt-get install -y nvidia-container-toolkit

sudo systemctl restart docker

# 运行容器

docker run -it --rm \

--gpus all \

nvidia/cuda:11.0-base nvidia-smi实践建议:

# 限制GPU使用数量

docker run -it --rm \

--gpus '"device=0,1"' \

nvidia/cuda:11.0-base nvidia-smi

# 检查GPU信息

docker run --rm --gpus all nvidia/cuda:11.0-base \

nvidia-smi --query-gpu=name --format=csv三、边缘场景特殊配置

1. 资源限制

# 内存限制(OOM时自动重启)

docker run -it --rm \

--memory=256m \

--memory-swap=256m \

--restart=on-failure:5 \

edge-app

# CPU限制(使用cgroup v2)

docker run -it --rm \

--cpus=0.5 \

--cpu-shares=512 \

edge-app2. 离线部署方案

# 保存镜像为tar包

docker save -o edge-app.tar edge-app:latest

# 在离线设备加载

docker load -i edge-app.tar

# 使用本地registry

docker run -d -p 5000:5000 \

--restart=always \

--name registry \

-v /mnt/registry:/var/lib/registry \

registry:2四、监控与调试技巧

1. 资源监控

# 精简版监控(适合边缘设备)

docker stats --no-stream \

--format "table {{.Container}}\t{{.CPUPerc}}\t{{.MemUsage}}"

# 使用cAdvisor(注意资源开销)

docker run -d \

--volume=/:/rootfs:ro \

--volume=/var/run:/var/run:ro \

--volume=/sys:/sys:ro \

--volume=/var/lib/docker/:/var/lib/docker:ro \

--publish=8080:8080 \

--name=cadvisor \

--privileged \

--device=/dev/kmsg \

gcr.io/cadvisor/cadvisor:v0.47.02. 日志管理

# 限制日志大小(防止占满磁盘)

docker run -it --rm \

--log-driver=json-file \

--log-opt max-size=10m \

--log-opt max-file=3 \

edge-app

# 关键日志过滤

docker logs edge-app | grep -E "ERROR|WARN"结语:边缘容器设计原则

- 极简主义:镜像能小则小,进程能少则少

- 明确边界:设备访问按需分配,避免滥用

--privileged - 韧性设计:考虑自动恢复和离线场景

- 监控先行:资源使用情况必须可视化

通过以上实践,Docker可以在边缘计算场景中发挥巨大价值,将云计算的能力延伸到网络边缘。在实际部署时,建议结合具体硬件和业务需求进行调优。