Spring Batch批处理框架实战:核心配置与最佳实践

Spring Batch批处理框架实战指南

Spring Batch是Spring生态中用于构建健壮批处理应用程序的轻量级框架。本文将深入讲解其核心概念、配置方式以及与任务调度系统的集成。

一、批处理框架核心概念

1. Job与Step基础模型

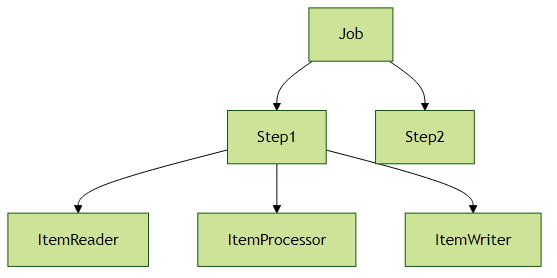

Spring Batch的核心抽象由Job和Step构成:

- Job:代表完整的批处理作业,由多个Step组成

- Step:作业中的单个处理步骤,包含实际业务逻辑

2. 基础配置示例

@Configuration

@EnableBatchProcessing

public class BatchConfig {

@Autowired

private JobBuilderFactory jobBuilderFactory;

@Autowired

private StepBuilderFactory stepBuilderFactory;

@Bean

public Job importUserJob(Step step1) {

return jobBuilderFactory.get("importUserJob")

.incrementer(new RunIdIncrementer())

.flow(step1)

.end()

.build();

}

@Bean

public Step step1(ItemReader<User> reader,

ItemProcessor<User, User> processor,

ItemWriter<User> writer) {

return stepBuilderFactory.get("step1")

.<User, User> chunk(10)

.reader(reader)

.processor(processor)

.writer(writer)

.build();

}

}实践建议:

- 使用

@EnableBatchProcessing开启批处理支持 - 每个Job应有明确的名称和增量器(如

RunIdIncrementer) - 合理设置chunk大小(影响内存使用和事务边界)

二、读写器(ItemReader/ItemWriter)详解

1. 常用ItemReader实现

| 类型 | 实现类 | 适用场景 |

|---|---|---|

| 数据库 | JdbcCursorItemReader | 大数据集游标读取 |

| 数据库 | JdbcPagingItemReader | 分页查询 |

| 文件 | FlatFileItemReader | CSV/固定格式文件 |

| 消息 | KafkaItemReader | Kafka消息消费 |

| 复合 | CompositeItemReader | 多数据源合并 |

文件读取示例:

@Bean

public FlatFileItemReader<User> reader() {

return new FlatFileItemReaderBuilder<User>()

.name("userItemReader")

.resource(new ClassPathResource("users.csv"))

.delimited()

.names("firstName", "lastName", "email")

.fieldSetMapper(new BeanWrapperFieldSetMapper<User>() {{

setTargetType(User.class);

}})

.build();

}2. 常用ItemWriter实现

| 类型 | 实现类 | 特点 |

|---|---|---|

| 数据库 | JdbcBatchItemWriter | 批量JDBC操作 |

| 文件 | FlatFileItemWriter | 文件输出 |

| 消息 | KafkaItemWriter | Kafka消息生产 |

| 复合 | CompositeItemWriter | 多目标写入 |

| 仓库 | RepositoryItemWriter | Spring Data仓库 |

数据库写入示例:

@Bean

public JdbcBatchItemWriter<User> writer(DataSource dataSource) {

return new JdbcBatchItemWriterBuilder<User>()

.itemSqlParameterSourceProvider(

new BeanPropertyItemSqlParameterSourceProvider<>())

.sql("INSERT INTO users (first_name, last_name, email) " +

"VALUES (:firstName, :lastName, :email)")

.dataSource(dataSource)

.build();

}实践建议:

- 大数据量处理优先选择游标或分页读取

- 数据库写入使用批量操作提升性能

- 考虑实现

ItemReadListener和ItemWriteListener进行监控

三、任务调度与Quartz集成

1. 基础调度配置

@Configuration

public class SchedulerConfig {

@Autowired

private JobLauncher jobLauncher;

@Autowired

private Job importUserJob;

@Scheduled(cron = "0 0 2 * * ?")

public void perform() throws Exception {

JobParameters params = new JobParametersBuilder()

.addString("JobID", String.valueOf(System.currentTimeMillis()))

.toJobParameters();

jobLauncher.run(importUserJob, params);

}

}2. 与Quartz深度集成

@Configuration

public class QuartzConfig {

@Bean

public JobDetailFactoryBean jobDetail() {

return new JobDetailFactoryBean() {{

setJobClass(QuartzJobLauncher.class);

setDurability(true);

setJobDataAsMap(new HashMap<String, Object>() {{

put("jobName", "importUserJob");

}});

}};

}

@Bean

public SimpleTriggerFactoryBean trigger(JobDetail job) {

return new SimpleTriggerFactoryBean() {{

setJobDetail(job);

setStartDelay(0);

setRepeatInterval(60000);

}};

}

}

public class QuartzJobLauncher extends QuartzJobBean {

@Autowired

private JobLauncher jobLauncher;

@Autowired

private ApplicationContext context;

@Override

protected void executeInternal(JobExecutionContext ctx) {

String jobName = ctx.getJobDetail().getJobDataMap().getString("jobName");

Job job = context.getBean(jobName, Job.class);

// 执行逻辑...

}

}实践建议:

- 生产环境建议使用Quartz替代

@Scheduled - 为每个Job执行记录唯一标识便于追踪

- 考虑实现

JobExecutionListener监控执行状态

四、高级特性与优化

1. 并行处理

@Bean

public Step parallelStep() {

return stepBuilderFactory.get("parallelStep")

.<User, User>chunk(100)

.reader(reader())

.writer(writer())

.taskExecutor(new SimpleAsyncTaskExecutor()) // 并行执行

.throttleLimit(5) // 并发限制

.build();

}2. 事务与重试

@Bean

public Step faultTolerantStep() {

return stepBuilderFactory.get("faultTolerantStep")

.<User, User>chunk(10)

.reader(reader())

.writer(writer())

.faultTolerant()

.skipLimit(10)

.skip(DataIntegrityViolationException.class)

.retryLimit(3)

.retry(DeadlockLoserDataAccessException.class)

.build();

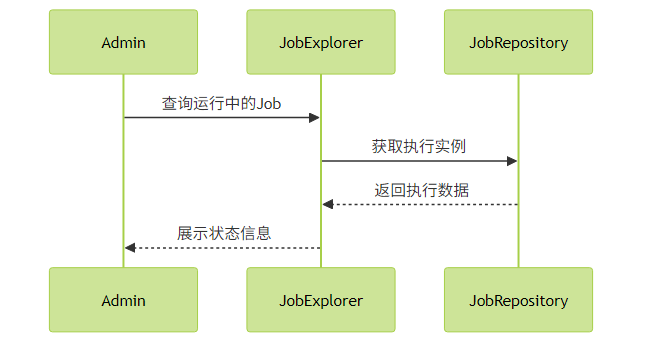

}3. 批处理监控

实践建议:

- 大任务考虑分片处理(Partitioning)

- 合理配置跳过和重试策略提高容错性

- 使用Spring Batch Admin或自定义监控界面

五、常见问题解决方案

内存溢出问题:

- 使用分页读取替代游标

- 调整chunk大小

- 实现ItemStream接口管理资源

作业重启控制:

.incrementer(new RunIdIncrementer()) .preventRestart() // 禁止重启性能优化:

- 启用JdbcBatchItemWriter的批处理

- 使用异步ItemProcessor

- 考虑远程分块(Remote Chunking)

Spring Batch提供了企业级批处理所需的各种功能,合理运用可以构建出高效可靠的批处理系统。建议根据实际业务需求选择合适的组件和配置策略。