ELK数据处理指南:日志解析与增强技术

ELK数据处理全解析:从日志解析到数据增强

在ELK Stack中,数据处理是将原始日志转化为可搜索、可分析信息的关键环节。本文将深入探讨ELK中的数据处理技术,包括数据解析、增强和转换三大核心功能。

一、数据解析:从原始日志到结构化数据

1. 结构化日志处理

结构化日志(如JSON格式)天生适合ELK处理,Logstash可以直接解析:

{

"timestamp": "2023-05-15T14:32:45Z",

"level": "ERROR",

"message": "Database connection failed",

"service": "order-service"

}对应的Logstash配置:

input {

file {

path => "/var/log/app/*.json"

codec => "json"

}

}实践建议:在应用程序中直接输出JSON格式日志,可以显著减少后续解析的工作量。

2. 非结构化日志解析(Grok模式)

对于非结构化日志,Grok是Logstash中最强大的解析工具:

示例日志:

2023-05-15 14:32:45 [ERROR] order-service: Database connection failedGrok模式:

filter {

grok {

match => { "message" => "%{TIMESTAMP_ISO8601:timestamp} \[%{LOGLEVEL:level}\] %{DATA:service}: %{GREEDYDATA:message}" }

}

}常用Grok模式:

%{IP:client}- 匹配IP地址%{NUMBER:duration}- 匹配数字%{WORD:method}- 匹配单词%{HTTPDATE:timestamp}- 匹配HTTP日期

实践建议:使用Grok Debugger在线工具测试和调试你的Grok模式。

3. 多行日志处理

处理堆栈跟踪等跨越多行的日志:

input {

file {

path => "/var/log/app/*.log"

codec => multiline {

pattern => "^\[%{TIMESTAMP_ISO8601}\]"

negate => true

what => "previous"

}

}

}实践建议:对于Java堆栈跟踪,可以使用pattern => "^\\s+at"来正确合并异常信息。

4. 日期时间解析与时区处理

filter {

date {

match => ["timestamp", "ISO8601"]

target => "@timestamp"

timezone => "Asia/Shanghai"

}

}实践建议:始终将日志时间转换为UTC存储在@timestamp字段,在Kibana中再按需显示本地时间。

二、数据增强:丰富日志信息

1. GeoIP地理位置信息添加

filter {

geoip {

source => "client_ip"

target => "geo"

}

}输出结果示例:

{

"geo": {

"city_name": "Beijing",

"country_name": "China",

"location": {

"lat": 39.9042,

"lon": 116.4074

}

}

}实践建议:GeoIP数据库需要定期更新,可以使用geoip { database => "/path/to/GeoLite2-City.mmdb" }指定最新数据库。

2. 用户代理(User Agent)解析

filter {

useragent {

source => "user_agent"

target => "ua"

}

}解析结果示例:

{

"ua": {

"name": "Chrome",

"version": "92.0.4515.107",

"os": "Mac OS X 10.15.7",

"device": "Other"

}

}3. 字段操作

filter {

# 添加字段

add_field => { "environment" => "production" }

# 重命名字段

rename => { "old_field" => "new_field" }

# 删除字段

remove_field => ["debug_info", "temp_field"]

# 条件字段处理

if [status] == 404 {

add_tag => ["not_found"]

}

}实践建议:尽早删除不需要的字段,可以减少存储空间和提高查询性能。

三、数据转换:格式处理与标准化

1. JSON编码/解码

filter {

# 将字段编码为JSON字符串

json {

source => "data_map"

target => "data_json"

}

# 解码JSON字符串为字段

json {

source => "json_payload"

target => "payload"

}

}2. CSV处理

filter {

csv {

columns => ["name", "age", "city"]

separator => ","

source => "message"

}

}3. XML解析

filter {

xml {

source => "xml_data"

target => "parsed_xml"

store_xml => false

xpath => [

"/root/name", "name",

"/root/age", "age"

]

}

}4. 数据格式标准化

filter {

# 转换为小写

mutate {

lowercase => ["log_level"]

}

# 转换为整数

mutate {

convert => {

"response_time" => "integer"

"score" => "float"

}

}

# 替换文本

mutate {

gsub => [

"message", "\t", " ",

"path", "/", "_"

]

}

}实践建议:建立统一的数据标准(如所有URL字段命名为url,所有时间字段使用ISO8601格式),可以大大简化后续的分析工作。

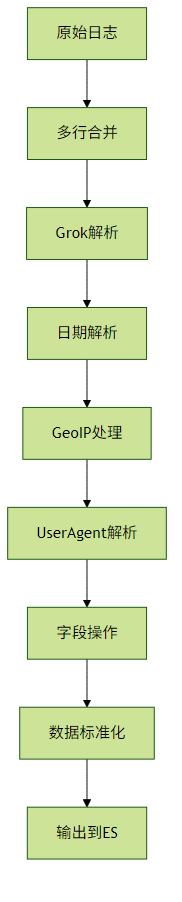

四、数据处理流程示例

五、性能优化建议

条件处理:使用

if条件避免不必要的过滤操作filter { if [type] == "apache" { grok { ... } } }- 批量处理:调整

pipeline.batch.size和pipeline.batch.delay参数 - 插件顺序:将最可能过滤掉事件的过滤器(如

drop)放在前面 缓存Grok模式:对于频繁使用的Grok模式,可以预编译

filter { grok { patterns_dir => ["/path/to/patterns"] match => { "message" => "%{MY_PATTERN:field}" } } }

通过合理运用这些数据处理技术,你可以将原始日志转化为结构清晰、信息丰富的高质量数据,为后续的搜索、分析和可视化打下坚实基础。