ELK生态系统集成指南:构建数据处理解决方案

ELK生态系统集成:构建全方位的数据处理解决方案

ELK Stack的强大之处不仅在于其核心组件的能力,更在于它与各种外部系统的无缝集成能力。本文将深入探讨ELK与各类数据源、可视化工具和告警系统的集成方法,帮助您构建一个完整的数据处理生态系统。

一、数据源集成

1. 关系型数据库集成

关系型数据库是企业中最常见的数据存储系统,ELK可以通过多种方式与其集成:

Logstash JDBC插件示例:

input {

jdbc {

jdbc_driver_library => "/path/to/mysql-connector-java.jar"

jdbc_driver_class => "com.mysql.jdbc.Driver"

jdbc_connection_string => "jdbc:mysql://localhost:3306/mydb"

jdbc_user => "user"

jdbc_password => "password"

schedule => "* * * * *" # 每分钟执行一次

statement => "SELECT * FROM orders WHERE updated_at > :sql_last_value"

use_column_value => true

tracking_column => "updated_at"

}

}实践建议:

- 对于频繁更新的表,使用增量查询策略(如示例中的

tracking_column) - 设置合理的

schedule参数避免对数据库造成过大压力 - 考虑使用主从架构,从从库读取数据减少主库压力

2. NoSQL数据库集成

对于MongoDB、Cassandra等NoSQL数据库,ELK提供了专门的集成方案:

MongoDB集成方案:

input {

mongodb {

uri => 'mongodb://localhost:27017/mydb'

placeholder_db_dir => '/opt/logstash-mongodb/'

placeholder_db_name => 'logstash_sqlite.db'

collection => 'products'

batch_size => 5000

}

}实践建议:

- 对于大数据量集合,使用分批次处理(

batch_size参数) - 考虑使用MongoDB的变更流(Change Stream)功能实现实时同步

- 对于Cassandra等数据库,可以使用Elasticsearch Connector实现直接同步

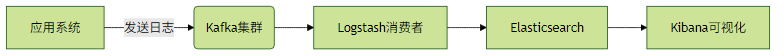

3. 消息队列集成

消息队列是现代分布式系统的核心组件,ELK与Kafka、RabbitMQ等主流消息队列有深度集成:

Kafka集成示例:

input {

kafka {

bootstrap_servers => "kafka1:9092,kafka2:9092"

topics => ["web_logs", "app_logs"]

codec => "json"

consumer_threads => 4

decorate_events => true

}

}消息队列集成架构:

实践建议:

- 根据消息量调整

consumer_threads参数实现并行消费 - 对于高吞吐场景,考虑使用Kafka Connect直接对接Elasticsearch

- 设置合理的消费者组(consumer group)实现负载均衡

4. 云服务日志集成

三大云服务商都提供了与ELK集成的方案:

AWS CloudWatch集成:

input {

cloudwatch {

namespace => "AWS/EC2"

metrics => ["CPUUtilization", "DiskReadOps"]

filters => { "tag:Environment" => "Production" }

region => "us-west-2"

aws_credentials => ["access_key_id", "secret_access_key"]

}

}实践建议:

- 利用IAM角色而非硬编码密钥实现安全访问

- 对于大量日志,考虑使用Kinesis Firehose作为中间缓冲层

- 设置合理的日志过滤条件避免数据过载

二、可视化集成

1. Grafana集成

虽然Kibana功能强大,但许多企业已经建立了基于Grafana的可视化体系:

Grafana配置Elasticsearch数据源:

apiVersion: 1

datasources:

- name: Elasticsearch-Prod

type: elasticsearch

url: http://elasticsearch:9200

access: proxy

database: "[logstash-]YYYY.MM.DD"

jsonData:

timeField: "@timestamp"

esVersion: 7.0.0

interval: "Daily"实践建议:

- 为不同环境(生产、测试等)创建独立的数据源配置

- 利用Grafana的变量功能实现动态索引模式选择

- 结合Elasticsearch的聚合能力构建高效的可视化查询

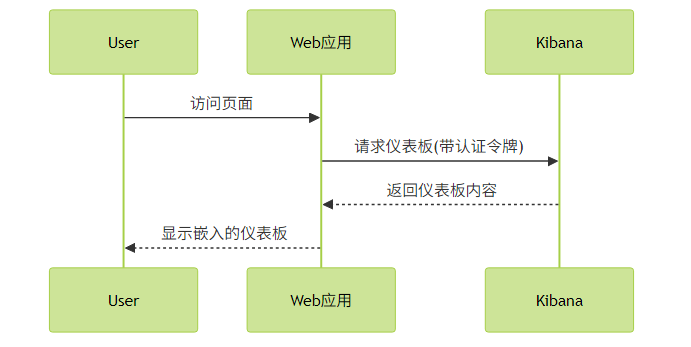

2. 自定义仪表板嵌入

将ELK可视化嵌入现有系统可以提升用户体验:

Kibana仪表板嵌入示例:

<iframe

src="http://kibana:5601/app/dashboards#/view/12345678-90ab-cdef-1234-567890abcdef"

height="600"

width="800"

style="border:none;">

</iframe>安全集成方案:

实践建议:

- 使用Kibana Spaces功能隔离不同业务的仪表板

- 通过Kibana的认证代理实现安全嵌入

- 考虑使用React等前端框架的官方Kibana嵌入组件

3. 报表导出

自动化报表是许多业务场景的刚需:

使用Kibana API生成PDF报表:

curl -X POST "http://kibana:5601/api/reporting/generate/printablePdf" \

-H "kbn-xsrf: true" \

-H "Content-Type: application/json" \

-d '{

"browserTimezone": "Asia/Shanghai",

"objectType": "dashboard",

"objectId": "12345678-90ab-cdef-1234-567890abcdef"

}'实践建议:

- 设置定时任务自动生成日报/周报

- 将生成的报表自动发送到指定邮箱或存储系统

- 对于复杂报表,考虑使用Elasticsearch SQL功能提取数据后自定义处理

三、告警集成

1. Webhook通知

Webhook提供了最灵活的告警集成方式:

Elasticsearch告警Webhook配置:

{

"name": "High Error Rate Alert",

"trigger": {

"schedule": {

"interval": "5m"

}

},

"input": {

"search": {

"request": {

"indices": ["logstash-*"],

"body": {

"query": {

"bool": {

"filter": [

{ "range": { "@timestamp": { "gte": "now-5m/m" } } },

{ "term": { "level": "ERROR" } }

]

}

},

"aggs": {

"error_count": { "value_count": { "field": "level" } }

}

}

}

}

},

"actions": {

"notify_webhook": {

"webhook": {

"scheme": "https",

"host": "alert.example.com",

"port": 443,

"method": "post",

"path": "/api/alerts",

"headers": {

"Content-Type": "application/json"

},

"body": "{\"text\":\"发现{{ctx.metadata.error_count}}条错误日志\"}"

}

}

}

}实践建议:

- 为Webhook接口实现认证机制确保安全性

- 在告警消息中包含关键上下文信息便于快速定位问题

- 设置合理的防抖动机制避免告警风暴

2. Email/SMS通知

传统通知方式仍然是许多场景的首选:

Email告警配置示例:

output {

if "alert" in [tags] {

email {

to => "ops-team@example.com"

from => "elk-alerts@example.com"

subject => "ALERT: %{alert_name}"

body => "发现告警: %{alert_message}"

via => "smtp"

options => {

address => "smtp.example.com"

port => 587

domain => "example.com"

authentication => "plain"

username => "user"

password => "password"

}

}

}

}实践建议:

- 为不同严重等级的告警设置不同的收件人列表

- 在邮件中包含直接跳转到相关Kibana仪表板的链接

- 考虑使用邮件模板系统提升告警邮件的可读性

3. 协作工具集成

现代团队协作工具如Slack、Teams等是理想的告警接收平台:

Slack集成配置:

{

"actions": {

"slack_alert": {

"throttle_period": "15m",

"slack": {

"message": {

"text": ":fire: *生产环境错误告警*\n> {{ctx.message}}",

"attachments": [

{

"text": "错误计数: {{ctx.metadata.error_count}}",

"color": "danger",

"actions": [

{

"name": "查看仪表板",

"text": "打开Kibana",

"type": "button",

"url": "http://kibana/dashboard/errors"

}

]

}

]

}

}

}

}

}实践建议:

- 为不同频道设置不同的告警路由规则

- 使用表情符号和颜色编码提升消息可读性

- 在消息中包含可直接操作的按钮(如确认告警)

四、集成最佳实践

性能考虑:

- 为数据集成设置合理的批处理大小和频率

- 监控集成管道的延迟和吞吐量

- 考虑使用消息队列作为缓冲层应对流量高峰

安全考虑:

- 使用最小权限原则配置数据源访问权限

- 加密敏感配置信息(如数据库密码)

- 定期审计集成访问日志

可维护性:

- 为每个集成管道编写清晰的文档

- 使用版本控制管理集成配置

- 建立集成测试流程确保配置变更不会破坏现有功能

通过以上集成方案,ELK Stack可以成为企业数据生态系统的核心枢纽,连接各类数据源、可视化工具和告警系统,构建完整的数据处理流水线。