Prometheus告警体系全解析:规则定义到通知实战

Prometheus告警体系深度解析:从规则定义到精准通知

一、告警规则(Alerting Rules)设计与实践

1.1 告警规则基础结构

Prometheus的告警规则文件(通常为.rules后缀)采用YAML格式,每个告警规则包含以下核心要素:

groups:

- name: example

rules:

- alert: HighErrorRate

expr: job:request_failures_per_second{job="myapp"} > 0.1

for: 5m

labels:

severity: critical

annotations:

summary: "High error rate on {{ $labels.instance }}"

description: "Error rate is {{ $value }}. Instance {{ $labels.instance }}"关键参数解析:

expr: PromQL表达式,定义触发条件(如up == 0表示服务下线)for: 持续时间,避免瞬时抖动触发误报(如5m表示持续5分钟才触发)labels: 附加标签,用于告警路由分类annotations: 告警详情模板,支持变量插值

1.2 阈值定义最佳实践

CPU使用率告警示例:

- alert: HighCPUUsage

expr: 100 - (avg by(instance) (irate(node_cpu_seconds_total{mode="idle"}[5m])) * 100) > 80

for: 10m

labels:

severity: warning实践建议:

- 使用

irate()而非rate()处理快速变化的计数器 - 对关键业务指标设置多级阈值(如warning/critical)

- 结合

avg by或sum by进行合理的维度聚合

1.3 告警持续时间(for)的黄金法则

| 场景类型 | 推荐持续时间 | 理由 |

|---|---|---|

| 基础设施宕机 | 1-2m | 快速响应硬件故障 |

| 应用错误率上升 | 5-10m | 避免部署或重启导致的瞬时波动 |

| 资源饱和度 | 15-30m | 给自动扩容留出缓冲时间 |

二、Alertmanager高级配置指南

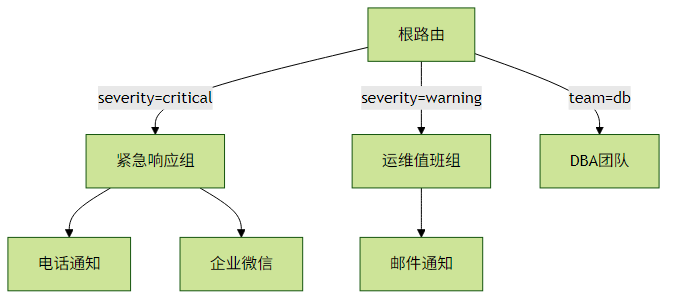

2.1 路由树(Routing Tree)设计

配置示例:

route:

receiver: 'default-receiver'

group_wait: 30s

group_interval: 5m

routes:

- match:

severity: 'critical'

receiver: 'critical-receiver'

- match_re:

service: ^(mysql|redis).*

receiver: 'db-team'2.2 抑制规则(Inhibition)实战

场景: 当整个机房断电时,抑制所有该机房内的实例告警

inhibit_rules:

- source_match:

alertname: 'DC_PowerFailure'

severity: 'critical'

target_match:

dc: 'east-1'

equal: ['alertname']抑制逻辑说明:

- 当存在

DC_PowerFailure告警时 - 自动静默所有带有

dc=east-1标签的其他告警 equal字段确保相同告警类型的抑制

2.3 接收器(Receiver)集成示例

邮件+Webhook混合配置:

receivers:

- name: 'email-and-webhook'

email_configs:

- to: 'team@example.com'

send_resolved: true

webhook_configs:

- url: 'http://alert-handler/api/v1/alerts'

timeout: 10s主流通知方式对比:

| 类型 | 延迟 | 可靠性 | 适用场景 |

|---|---|---|---|

| 邮件 | 1-5m | 中 | 非紧急事件汇总 |

| Webhook | <1s | 高 | 对接内部告警平台 |

| PagerDuty | <10s | 极高 | 生产事故SRE呼叫 |

| 企业微信 | 5-30s | 中 | 国内团队即时通知 |

三、Recording Rules性能优化

3.1 预计算规则设计

groups:

- name: http_requests_rules

rules:

- record: job:http_requests:rate5m

expr: sum by(job) (rate(http_requests_total[5m]))优化效果分析:

- 原始查询:

sum by(job)(rate(http_requests_total[5m]))每次执行需实时计算 - 预计算后:直接查询

job:http_requests:rate5m指标

3.2 命名规范建议

采用分层命名方案:

<聚合层级>:<原始指标>:<操作类型>

示例:

service:request_duration_seconds:avg_rate5m

env:memory_usage:percentile95四、告警生命周期管理

4.1 静默(Silence)管理技巧

临时静默创建:

# 静默所有关于instance=web-1的告警2小时

amtool silence add --alertmanager.url=http://alertmanager:9093 \

--comment="系统维护" \

--duration=2h \

instance="web-1"查看活跃静默:

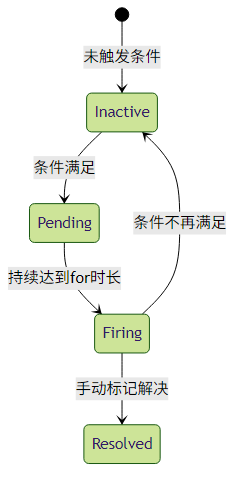

amtool silence --alertmanager.url=http://alertmanager:90934.2 告警状态流转

五、实战问题排查指南

常见问题1:告警未触发

- 检查Prometheus规则文件是否加载(

http://prometheus/rules) - 验证PromQL在Graph页面能否查询到数据

- 确认Alertmanager配置正确(

http://alertmanager/#/status)

常见问题2:通知重复

- 调整

group_wait和group_interval参数 - 检查路由树是否有多条匹配路径

- 验证抑制规则逻辑是否正确

推荐调试命令:

# 检查规则语法

promtool check rules /path/to/alert.rules

# 测试Alertmanager配置

amtool check-config /etc/alertmanager/config.yml六、演进趋势与扩展阅读

- Prometheus与OpenTelemetry集成:未来可能统一指标采集标准

- AI驱动的告警优化:自动调整阈值和静默规则

- 多租户告警管理:通过Cortex/Thanos实现

通过合理运用这些告警技术,可以构建出响应迅速、误报率低的智能监控体系。建议从简单规则开始,逐步迭代优化,最终形成适合自己业务场景的告警策略。