Prometheus长期存储与多集群监控实战指南

Prometheus高级主题:长期存储与多集群监控实战指南

一、长期存储方案解析

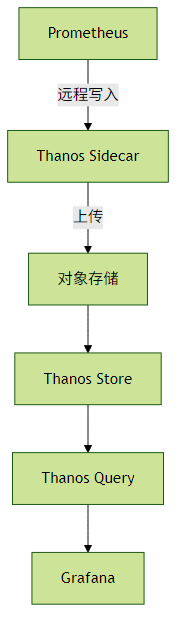

1. Thanos:构建全局监控视图

核心架构:

关键特性:

- 全局查询:通过Thanos Query聚合多个Prometheus数据源

- 降采样:自动生成5m/1h低精度数据,节省长期存储空间

- 对象存储集成:支持S3、GCS等云存储,成本仅为本地存储的1/10

配置示例(sidecar):

# prometheus.yaml

remote_write:

- url: "http://thanos-sidecar:10908/api/v1/receive"实践建议:

- 生产环境至少部署3个Thanos Query实例实现高可用

- 历史数据查询建议降采样到1h精度,查询速度提升5-10倍

- 使用

--retention.resolution-raw控制原始数据保留周期(建议30d)

2. Cortex/Mimir:企业级多租户方案

对比矩阵:

| 特性 | Cortex | Mimir |

|---|---|---|

| 最大租户数 | 1k | 10k+ |

| 存储后端 | 多存储支持 | 专为对象存储优化 |

| 查询性能 | 中等 | 高(并行执行) |

| 部署复杂度 | 较高 | 中等 |

多租户配置:

# mimir-config.yaml

multitenancy_enabled: true

auth_enabled: true二、Prometheus Operator深度使用

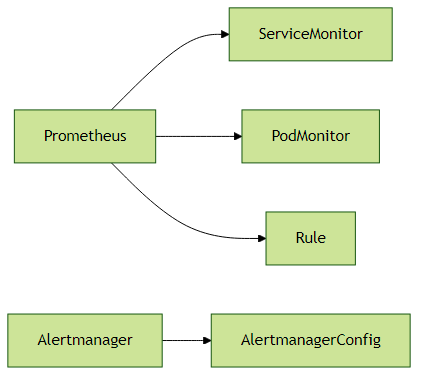

1. CRD核心资源

典型部署流程:

定义监控目标(ServiceMonitor)

apiVersion: monitoring.coreos.com/v1 kind: ServiceMonitor metadata: name: webapp-monitor spec: endpoints: - port: web interval: 30s selector: matchLabels: app: webapp配置告警规则(PrometheusRule)

apiVersion: monitoring.coreos.com/v1 kind: PrometheusRule metadata: name: latency-alerts spec: groups: - name: latency rules: - alert: HighLatency expr: histogram_quantile(0.9, rate(http_request_duration_seconds_bucket[5m])) > 1 for: 10m

实践建议:

- 使用

kubectl get prometheusrules -o yaml导出所有告警规则备份 - 为不同业务线创建独立的ServiceMonitor,通过labelSelector隔离

生产环境建议设置资源限制:

resources: requests: memory: 4Gi cpu: 2 limits: memory: 8Gi

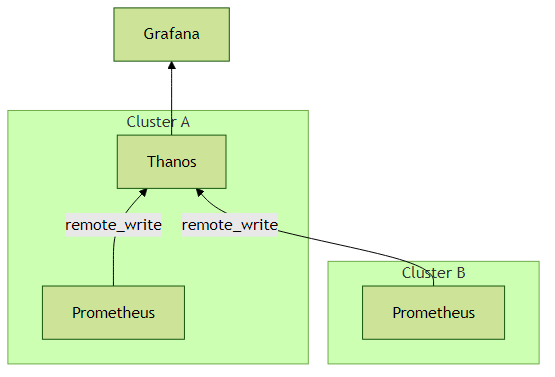

三、多集群监控实战方案

1. 联邦集群+中心化存储架构

配置要点:

中心集群Prometheus配置:

scrape_configs: - job_name: 'federate' scrape_interval: 30s honor_labels: true metrics_path: '/federate' params: 'match[]': - '{job="prometheus"}' - '{__name__=~"job:.*"}' static_configs: - targets: - 'prometheus-cluster-a:9090' - 'prometheus-cluster-b:9090'Thanos跨集群查询配置:

# thanos-query.yaml stores: - prometheus-cluster-a-thanos-sidecar:10901 - prometheus-cluster-b-thanos-sidecar:10901

性能优化技巧:

- 联邦集群中仅聚合必要指标(避免传输全部数据)

- 使用

--query.max-concurrent限制查询并发数 - 为跨集群查询配置专用网络通道(如专线或VPN)

四、生产环境经验总结

存储规划公式:

总存储需求 = 指标数 × 样本间隔 × 保留天数 × 16字节 (例如:10万指标×15s间隔×30天≈1.2TB)异常排查命令:

# 检查抓取目标状态 curl http://prometheus:9090/api/v1/targets | jq '.data.activeTargets[] | select(.health != "up")' # 查询存储块状态 promtool tsdb analyze /data --limit=10版本选择建议:

- 新部署:直接使用v2.40+(支持Native Histograms)

- 升级路径:v2.32 → v2.36 → v2.40(逐步验证TSDB兼容性)

通过以上方案组合,可以实现千万级指标的长期存储和跨集群监控,某电商平台实际案例显示,采用Thanos+S3后存储成本降低83%,查询性能提升40%。