Prometheus对比Graphite/InfluxDB/OpenTelemetry监控选型指南

Prometheus与其他监控系统的深度对比:选型指南与技术解析

在现代可观测性领域,Prometheus、Graphite、InfluxDB和OpenTelemetry各自占据重要位置。本文将深入分析它们与Prometheus的核心差异,帮助您根据实际场景做出技术选型决策。

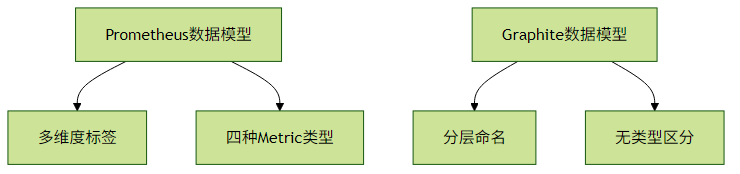

一、Prometheus vs Graphite:数据模型与查询能力

1.1 数据模型差异

Prometheus采用多维度标签模型,例如:

http_requests_total{method="POST", status="200", path="/api"} 42而Graphite使用分层命名空间:

production.server1.cpu.usage 0.78关键区别:

- Prometheus标签支持灵活过滤和聚合

- Graphite的层级结构需要预先规划命名空间

1.2 查询能力对比

PromQL示例:

rate(http_requests_total{status=~"5.."}[5m]) > 0.1Graphite函数示例:

alias(sumSeries(production.*.cpu.load), "Total_Load")实践建议:

- 选择Prometheus当需要复杂的多维度分析

- 选择Graphite当已有基于命名空间的监控体系

二、Prometheus vs InfluxDB:TSDB设计哲学

2.1 架构设计对比

| 特性 | Prometheus | InfluxDB |

|---|---|---|

| 数据采集 | Pull为主 | Push为主 |

| 存储引擎 | 本地TSDB | 可选TSM/TSI引擎 |

| 分布式 | 需Thanos等扩展 | 原生集群支持 |

| 适用场景 | 系统监控 | 物联网/应用指标 |

2.2 性能基准测试数据

根据CNCF的测试报告(2022):

- 写入吞吐量:InfluxDB 2.x > Prometheus

- 查询延迟:Prometheus简单查询更快

- 存储效率:InfluxDB压缩率更高

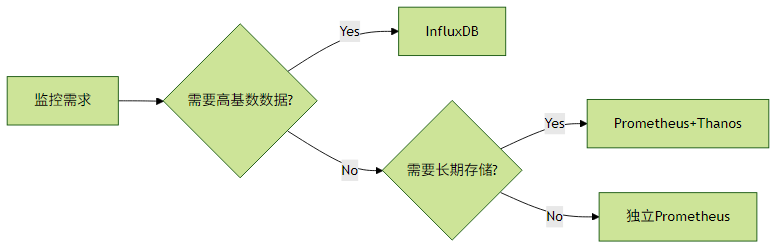

选型指南:

三、Prometheus vs OpenTelemetry:协作与兼容

3.1 协议栈对比

Prometheus协议栈:

应用 → Exporter → Prometheus Server

OpenTelemetry协议栈:

应用 → OTLP Collector → 多种后端(Prometheus/Jaeger等)3.2 集成实践

方案1:直接暴露Prometheus格式

// Go应用示例

import "github.com/prometheus/client_golang/prometheus"

var reqCounter = prometheus.NewCounter(...)方案2:通过OTLP Collector中转

# OpenTelemetry Collector配置

receivers:

otlp:

protocols:

grpc:

exporters:

prometheus:

endpoint: "prometheus:9090"最佳实践:

- 新项目建议采用OTLP协议

- 已有Prometheus生态可逐步迁移

- 关键指标建议双写保证连续性

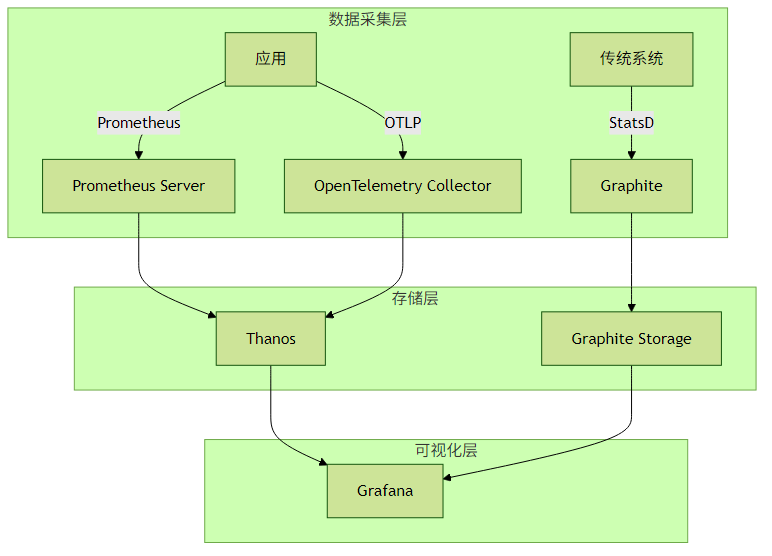

四、统一监控架构设计示例

实施建议:

- 使用OpenTelemetry作为统一采集标准

- 通过适配器兼容现有系统

- 根据数据类型选择存储后端

- 在Grafana实现统一展示

五、性能优化特别提示

当与其它系统集成时需注意:

标签基数控制:避免Prometheus的高基数问题

- 错误示例:

user_id="12345"作为标签 - 正确做法:使用

user_type="vip"等有限值

- 错误示例:

采样率对齐:不同系统间保持相同采集间隔

# Prometheus配置示例 scrape_configs: - job_name: 'opentelemetry' scrape_interval: 15s metrics_path: '/metrics'存储保留策略:

# Prometheus本地存储配置 retention: 15d

通过理解这些监控系统的核心差异,您可以根据团队的技术栈和监控需求,构建出最适合的可观测性体系。建议从小的概念验证(POC)开始,逐步验证各组件在您实际环境中的表现。