Neo4j扩展实战:APOC与GDS深度解析

Neo4j高级扩展与集成实战:APOC、GDS与生态工具深度解析

作为原生图数据库的代表,Neo4j的强大之处不仅在于其核心引擎,更在于其丰富的扩展生态。本文将深入探讨Neo4j的三大扩展利器:APOC库、图数据科学库(GDS)以及常用集成工具,通过实际案例展示如何释放图数据的全部潜力。

一、APOC:Neo4j的"瑞士军刀"

APOC (Awesome Procedures On Cypher) 是Neo4j最核心的扩展库,提供了超过450个存储过程和函数,覆盖数据转换、图算法、批量操作等场景。

1.1 核心功能解析

数据导入/导出实战:

// 从JSON文件导入数据

CALL apoc.import.json("file:///users.json",

{nodeLabels: true, unwindBatchSize: 1000})

// 导出子图为CSV

MATCH path = (u:User)-[:FRIEND]->(f)

CALL apoc.export.csv.data(

nodes(path),

relationships(path),

"friendships.csv", {}

)批量更新最佳实践:

// 使用apoc.periodic.iterate高效批量处理

CALL apoc.periodic.iterate(

"MATCH (u:User) WHERE u.credit IS NULL RETURN u",

"SET u.credit = 1000",

{batchSize:5000, parallel:true}

)实践建议:

- 大数据量导入时,优先使用

apoc.load.json/csv而非LOAD CSV - 批量操作务必设置合理的

batchSize(通常5000-10000) - 启用

parallel:true时注意避免写冲突

1.2 图算法应用

PageRank计算社交影响力:

CALL apoc.algo.pageRank(

'MATCH (u:User) RETURN id(u) as id',

'MATCH (u1:User)-[:FOLLOWS]->(u2:User)

RETURN id(u1) as source, id(u2) as target',

{iterations:20, write:true, property:'pagerank'}

)社区检测发现用户群体:

CALL apoc.algo.louvain(

'MATCH (u:User) RETURN id(u) as id',

'MATCH (u1:User)-[:INTERACTS]-(u2:User)

RETURN id(u1) as source, id(u2) as target,

count(*) as weight',

{write:true, property:'community'}

)算法选择指南:

- 影响力分析:PageRank, ArticleRank

- 群体发现:Louvain, Label Propagation

- 关键节点识别:Betweenness Centrality

二、图数据科学库(GDS)深度应用

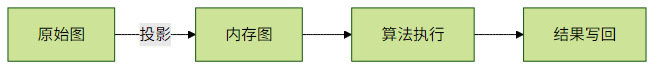

GDS库提供了生产级的图算法实现,支持内存图投影和流水线操作。

2.1 内存图投影模式

创建投影图:

CALL gds.graph.project(

'social_graph',

'User',

{

FOLLOWS: {orientation: 'NATURAL'},

INTERACTS: {properties: 'count'}

}

)2.2 典型算法实战

Betweenness中心性:

CALL gds.betweenness.stream('social_graph')

YIELD nodeId, score

RETURN gds.util.asNode(nodeId).name AS name, score

ORDER BY score DESC

LIMIT 10Jaccard相似度推荐:

MATCH (u:User {id: '123'})

CALL gds.nodeSimilarity.filtered.stream(

'social_graph',

{sourceNodeFilter: id(u), targetNodeFilter: 'MATCH (n) WHERE n <> $source RETURN id(n) as id'}

)

YIELD targetNodeId, similarity

RETURN gds.util.asNode(targetNodeId).name AS user, similarity

ORDER BY similarity DESC性能优化技巧:

- 对小规模图使用

gds.<algorithm>.stream避免写开销 - 对大规模图使用

mutate+write分阶段处理 - 配置

relationshipWeightProperty利用权重信息

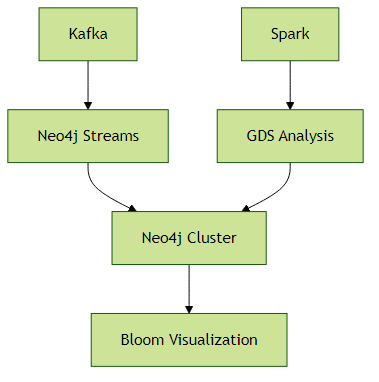

三、生态工具集成

3.1 Neo4j Bloom可视化

// 创建Bloom透视

CREATE PERSPECTIVE "FraudDetection"

SET {

nodes: {

User: {

caption: "name",

color: "case({fraudRisk: 'high'}, '#FF0000', '#00FF00')"

}

},

relationships: {

TRANSFERS: {

caption: "amount",

width: "log10(toInteger(amount))"

}

}

}3.2 Kafka实时数据管道

// 使用Neo4j Streams Sink Connector配置示例

{

"name": "fraud-events-sink",

"config": {

"topics": "fraud.alerts",

"connector.class": "streams.kafka.sink.Neo4jSinkConnector",

"neo4j.server.uri": "bolt://neo4j:7687",

"neo4j.authentication.username": "neo4j",

"neo4j.authentication.password": "secret",

"value.converter": "org.apache.kafka.connect.json.JsonConverter",

"errors.tolerance": "all",

"neo4j.topic.cypher.fraud.alerts":

"MERGE (u:User {id: event.userId}) SET u.fraudFlag = true"

}

}3.3 Spark大规模处理

# PySpark连接Neo4j示例

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("Neo4jIntegration").getOrCreate()

df = spark.read.format("org.neo4j.spark.DataSource") \

.option("url", "bolt://localhost:7687") \

.option("query", "MATCH (u:User) RETURN id(u) as id, u.name as name") \

.load()

df.write.format("org.neo4j.spark.DataSource") \

.option("url", "bolt://localhost:7687") \

.option("labels", ":User:Processed") \

.mode("Append") \

.save()集成模式选择:

- 实时场景:Kafka + Neo4j Streams

- 批处理场景:Spark Connector

- 交互式分析:Neo4j BI Connector

四、架构实践建议

扩展资源分配:

# neo4j.conf 配置示例 dbms.memory.heap.initial_size=8G dbms.memory.heap.max_size=8G dbms.memory.pagecache.size=10G dbms.security.procedures.unrestricted=apoc.*,gds.*- 混合架构示例:

监控指标重点:

- APOC/GDS内存使用

- 算法执行时间

- 扩展过程调用频率

通过合理组合APOC、GDS和生态工具,可以构建从数据摄入、实时处理到高级分析的完整图数据管道。建议根据业务场景选择合适的技术组合,并持续监控扩展组件的性能表现。