关系型数据库迁移Neo4j指南:ETL实践与优化

从关系型数据库到Neo4j:高效数据迁移与ETL实践指南

为什么需要迁移到图数据库?

传统关系型数据库在处理高度互联数据时面临显著的性能挑战。当您的应用涉及以下场景时,考虑迁移到Neo4j图数据库将获得显著优势:

- 多层级关系查询(如社交网络的"朋友的朋友")

- 复杂路径分析(如供应链追溯、欺诈环检测)

- 动态模式演进(频繁新增的关系类型)

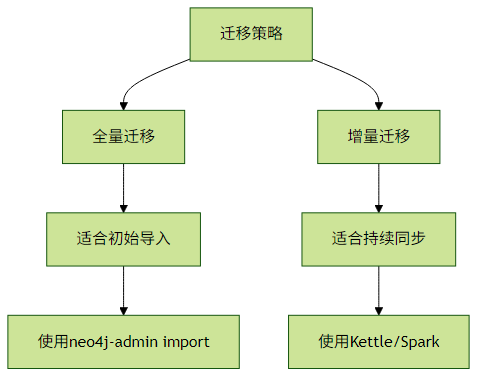

迁移策略选择

1. 全量迁移 vs 增量迁移

实践建议:

- 首次迁移选择全量迁移确保数据一致性

- 生产环境建议建立增量迁移管道

批量导入工具详解

1. neo4j-admin import(最高效方式)

这是Neo4j官方提供的高性能导入工具,适合TB级数据初始化导入。

neo4j-admin import \

--nodes=Customer=import/customers.csv \

--nodes=Product=import/products.csv \

--relationships=ORDERED=import/orders.csv \

--delimiter="," \

--array-delimiter="|"关键优化点:

- CSV文件需按节点/关系分类

- 使用

--id-type=STRING处理原有主键 - 并行导入使用

--processors=8(根据CPU核心调整)

示例CSV格式:

# customers.csv

customerId:ID(Customer),name,age:int

c1,John Smith,35

c2,Maria Garcia,28

# orders.csv

:START_ID(Customer),:END_ID(Product),date,amount:float

c1,p1,2023-01-15,299.992. LOAD CSV(中小规模数据)

适合百万级以下数据的增量导入:

LOAD CSV WITH HEADERS FROM 'file:///products.csv' AS row

MERGE (p:Product {id: row.id})

SET p.name = row.name,

p.price = toFloat(row.price)性能优化技巧:

- 使用

USING PERIODIC COMMIT 10000分批提交 - 预先创建索引加速MERGE操作

- 使用参数化查询避免重复解析

CREATE INDEX product_id_index IF NOT EXISTS FOR (p:Product) ON (p.id);

:param csvFile => "file:///data.csv";

LOAD CSV WITH HEADERS FROM $csvFile AS row

...第三方ETL工具集成

1. Apache Spark连接器

适合分布式处理PB级数据迁移:

val df = spark.read.jdbc(relationalDBUrl, "customers", props)

df.write.format("org.neo4j.spark.DataSource")

.option("url", neo4jUrl)

.option("labels", "Customer")

.option("node.keys", "customer_id:id")

.save()最佳实践:

- 设置

spark.neo4j.batch.size=5000平衡吞吐与内存 - 使用

partitionColumn实现并行读取 - 对关系型表进行预处理减少JOIN操作

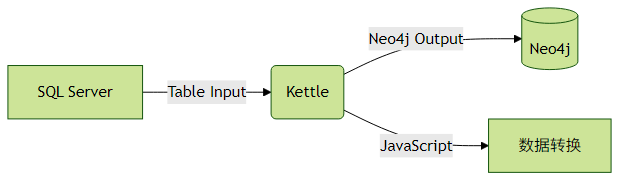

2. Kettle (Pentaho) 集成

图形化ETL工具适合业务人员使用:

关键配置:

- 使用"Neo4j Output"步骤

- 在"Graph Model"中定义节点/关系映射

- 启用"Batch insert"提升性能

数据模型转换模式

从关系模型到图模型的常见转换策略:

| 关系型结构 | 图模型转换 | 示例 |

|---|---|---|

| 主表 | 节点 | 客户表 → (c:Customer) |

| 从表 | 节点+关系 | 订单表 → (o:Order)-[:PLACED_BY]->(c) |

| 关联表 | 关系 | 用户角色表 → (u)-[:HAS_ROLE]->(r) |

| 外键 | 关系 | 订单商品表 → (o)-[:CONTAINS]->(p) |

复杂转换案例:

-- 关系型SQL(多表JOIN)

SELECT o.order_id, c.name, p.product_name

FROM orders o

JOIN customers c ON o.cust_id = c.cust_id

JOIN order_items oi ON o.order_id = oi.order_id

JOIN products p ON oi.product_id = p.product_id转换为Cypher查询:

MATCH (c:Customer)-[:PLACED]->(o:Order)-[:CONTAINS]->(p:Product)

RETURN o.id, c.name, p.name迁移后验证 Checklist

数据完整性验证

- 节点/关系计数对比

- 关键属性值抽样检查

性能基准测试

- 执行典型查询对比响应时间

- 并发压力测试

应用兼容性测试

- API接口验证

- 事务边界检查

常见问题解决方案

Q:如何处理关系型数据库中的NULL值?

A:Neo4j中不存在的属性不等同于NULL,建议:

- 迁移时过滤NULL字段,或

- 显式设置为默认值:

SET prop: CASE WHEN row.val IS NULL THEN 'default' ELSE row.val END

Q:超大规模数据迁移如何优化?

A:采用分片策略:

- 按业务单元拆分迁移批次

- 使用

UNWIND range(0,100,10) AS batch分批处理 - 考虑使用Neo4j Fabric进行分片存储

Q:如何实现实时双向同步?

A:推荐架构:

关系数据库 → CDC → Kafka → Neo4j Sink Connector

↗

应用更新 → Neo4j → 通过触发器同步回关系库结语

迁移到图数据库是需要周密规划的技术决策。建议:

- 从小规模概念验证(POC)开始

- 逐步迁移非关键业务数据

- 建立完善的监控和回滚机制

通过合理的ETL设计和工具选择,您可以充分发挥Neo4j处理关联数据的优势,同时最小化迁移风险。