JMeter测试分析指南:结果解读与可视化报告

JMeter测试分析与报告:从数据解读到可视化呈现

作为性能测试的关键环节,测试结果的分析与报告直接影响着对系统性能的准确评估。本文将深入讲解JMeter在结果分析、报告生成和性能指标解读方面的核心功能,帮助您从海量测试数据中提取有价值的信息。

一、结果分析:挖掘性能数据背后的故事

1. 响应时间分析

响应时间是衡量系统性能最直观的指标之一。JMeter提供了多种方式来分析响应时间:

// 示例:通过BeanShell获取响应时间

long responseTime = prev.getTime(); // 获取上一个采样器的响应时间(毫秒)

log.info("当前请求响应时间:" + responseTime + "ms");关键指标解读:

- 平均响应时间:所有请求响应时间的平均值

- 最小/最大响应时间:反映系统处理能力的边界值

- 标准差:显示响应时间的波动情况

实践建议:

- 关注响应时间随并发用户数增长的变化曲线

- 结合业务需求设定合理的响应时间阈值

- 对异常响应时间(突然飙升)要特别关注

2. 吞吐量计算

吞吐量(Throughput)表示系统在单位时间内处理的请求数量,通常以"请求数/秒"为单位。

吞吐量计算公式:

Throughput = (请求总数) / (测试总时间)分析要点:

- 吞吐量随并发用户数的变化趋势

- 系统最大吞吐量(性能拐点)

- 吞吐量与响应时间的关系

实践建议:

- 当吞吐量不再随并发数增加而增长时,系统可能已达到性能瓶颈

- 比较不同测试场景下的吞吐量差异

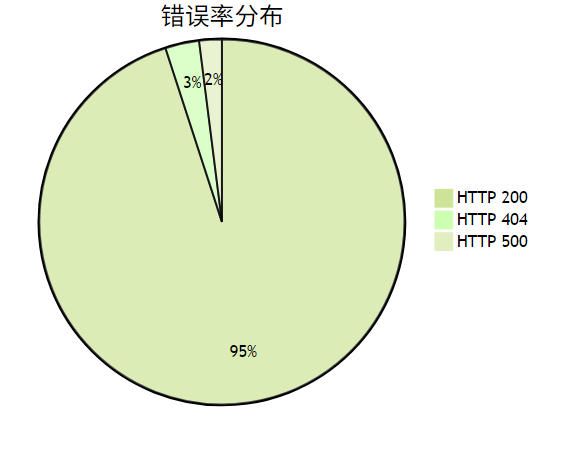

3. 错误率统计

错误率(Error %)反映了系统在压力下的稳定性。

常见错误类型:

- 4xx错误:客户端问题(如参数错误)

- 5xx错误:服务端问题(如服务崩溃)

- 连接超时:网络或服务处理能力不足

实践建议:

- 错误率超过1%通常需要重点关注

- 结合日志分析错误发生的具体场景

4. 百分位分析

百分位指标(如90%、95%)能更好地反映用户体验。

为什么需要百分位分析?

- 平均值可能掩盖极端情况

- 90%百分位表示90%的请求响应时间低于该值

实践建议:

- 电商类应用建议关注90%和95%百分位

- 金融类应用建议关注99%百分位

二、报告生成:专业直观的结果展示

1. HTML报告仪表板

JMeter提供一键生成HTML报告功能:

# 生成HTML报告命令

jmeter -n -t test.jmx -l result.jtl -e -o /path/to/report报告包含的核心部分:

- 测试结果概览(APDEX分数、请求统计)

- 响应时间随时间变化曲线

- 吞吐量随时间变化曲线

- 各采样器的详细指标

实践建议:

- 使用

-e -o参数自动生成报告 - 报告目录应为空目录,否则可能生成失败

2. 自定义报告模板

JMeter支持通过修改report-template目录自定义报告:

report-template/

├── content/

│ ├── pages/ # 自定义页面

│ └── stats.json # 数据统计模板

└── static/ # 静态资源(CSS/JS)定制化建议:

- 添加公司logo和测试背景说明

- 调整图表配色方案

- 增加特定业务指标的分析

3. 图表导出

JMeter支持将图表导出为多种格式:

导出方式:

- 右键点击图表 → "Save as image"

- 从HTML报告中直接截图

- 使用监听器配置自动保存图表数据

实践建议:

- 关键图表建议保存为PNG格式

- 原始数据可导出为CSV供进一步分析

三、性能指标:全面评估系统表现

1. 核心性能指标解读

| 指标名称 | 计算公式 | 理想值参考 |

|---|---|---|

| 平均响应时间 | 总响应时间/请求数 | <1s(Web页面) |

| 吞吐量 | 请求总数/测试时长 | 越高越好 |

| 错误率 | 错误请求数/总请求数 × 100% | <1% |

| 90%百分位 | 排序后90%位置的响应时间 | <平均值的2倍 |

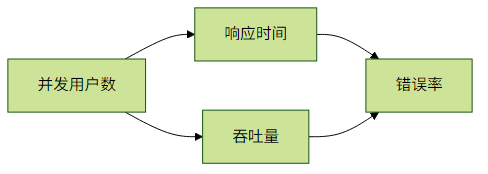

2. 指标关联分析

分析模式识别:

- 响应时间增加但吞吐量不变 → 可能遇到性能瓶颈

- 错误率突然飙升 → 可能系统资源耗尽

- 吞吐量先增后平 → 找到系统最佳并发数

3. 进阶指标监控

服务器资源指标:

- CPU使用率(建议<70%)

- 内存使用率(建议<80%)

- 磁盘I/O

- 网络带宽

JMeter监控插件:

- PerfMon Metrics Collector

- Prometheus Listener

- InfluxDB Backend Listener

实践建议:

- 建立性能基线(Baseline)用于对比

- 定期执行性能测试监控系统退化

四、最佳实践与常见问题

1. 测试结果分析流程

- 初步检查:查看错误率和响应时间是否在预期范围内

- 趋势分析:观察指标随时间/负载的变化趋势

- 关联分析:交叉对比不同指标的关系

- 根因定位:结合日志和监控数据定位问题

- 优化验证:调整后重新测试验证效果

2. 常见问题解决

问题1:测试结果波动大

- 解决方案:确保测试环境稳定,增加测试时长

问题2:HTML报告生成失败

- 检查:确保输出目录为空且有写入权限

问题3:监听器导致内存溢出

- 建议:在正式负载测试时禁用图形监听器

3. 性能优化方向

JMeter自身优化:

- 使用命令行模式(non-GUI)

- 减少不必要的监听器

- 合理设置JVM内存参数

测试脚本优化:

- 参数化重复数据

- 使用CSV数据集代替硬编码

- 合理设置思考时间和定时器

五、总结

JMeter提供了从测试执行到结果分析的完整解决方案。通过本文介绍的分析方法和报告技术,您可以:

- 深入理解系统在不同负载下的表现

- 快速识别性能瓶颈和稳定性问题

- 生成专业报告与团队高效沟通

- 基于数据做出合理的优化决策

最终建议: 建立性能测试的持续集成流程,将JMeter与Jenkins等工具集成,实现自动化测试和分析,让性能监控成为开发周期中的常态化工作。