Netty云原生实践:Kubernetes与Service Mesh集成指南

Netty云原生适配:Kubernetes集成与Service Mesh实战

一、Kubernetes集成:服务发现与健康检查机制

1.1 服务发现实现方案

在Kubernetes环境中,Netty服务需要动态感知上下游实例的变化。常见实现方式:

// 使用Kubernetes Java客户端实现Endpoint监听

public class K8sServiceDiscovery {

private final CoreV1Api api = new CoreV1Api();

private final String namespace = "default";

private final String serviceName = "netty-service";

public void watchEndpoints() {

try {

Watch<V1Endpoints> watch = Watch.createWatch(

apiClient,

api.listNamespacedEndpointsCall(

namespace, null, null, null,

"metadata.name=" + serviceName,

null, null, null, null, Boolean.TRUE, null

),

new TypeToken<Watch.Response<V1Endpoints>>(){}.getType()

);

watch.forEach(response -> {

List<V1EndpointAddress> addresses = response.object

.getSubsets().get(0).getAddresses();

// 更新本地服务列表

updateServerList(addresses);

});

} catch (ApiException e) {

logger.error("Watch endpoints failed", e);

}

}

}实践建议:

- 使用

Kubernetes Java Client比直接调用API更高效 - 考虑增加本地缓存避免频繁API调用

- 实现

AbstractLoadBalancer接口支持多种负载策略

1.2 健康检查机制设计

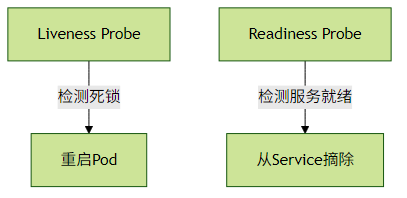

Kubernetes通过两类探针管理应用生命周期:

Netty侧需要实现的健康检查Handler示例:

public class HealthCheckHandler extends ChannelInboundHandlerAdapter {

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg) {

if (msg instanceof HttpRequest) {

HttpRequest req = (HttpRequest) msg;

if (req.uri().equals("/healthz")) {

ByteBuf content = Unpooled.copiedBuffer("OK", CharsetUtil.UTF_8);

FullHttpResponse response = new DefaultFullHttpResponse(

HTTP_1_1, OK, content);

response.headers().set(CONTENT_TYPE, "text/plain");

response.headers().set(CONTENT_LENGTH, content.readableBytes());

ctx.writeAndFlush(response);

return;

}

}

ctx.fireChannelRead(msg);

}

}关键配置参数:

# deployment.yaml片段

livenessProbe:

httpGet:

path: /healthz

port: 8080

initialDelaySeconds: 30

periodSeconds: 5

readinessProbe:

tcpSocket:

port: 8080

initialDelaySeconds: 5

periodSeconds: 10二、Service Mesh集成:与Istio/Envoy的Sidecar协作

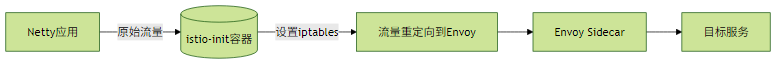

2.1 流量劫持原理

Istio通过iptables规则实现透明流量劫持:

2.2 关键适配点

连接保持时间调整:

// 需要与Envoy超时设置匹配 ServerBootstrap b = new ServerBootstrap(); b.option(ChannelOption.CONNECT_TIMEOUT_MILLIS, 1000) .childOption(ChannelOption.SO_KEEPALIVE, true) .childOption(ChannelOption.SO_LINGER, 5);Header传播处理:

public class TracePropagationHandler extends ChannelDuplexHandler { @Override public void write(ChannelHandlerContext ctx, Object msg, ChannelPromise promise) { if (msg instanceof HttpRequest) { HttpRequest req = (HttpRequest) msg; req.headers().add("x-b3-traceid", MDC.get("traceId")); } ctx.write(msg, promise); } }

性能优化建议:

- 关闭Netty自带的HTTP/2协议栈(由Envoy处理)

- 调整

SO_REUSEPORT参数提升Sidecar并行处理能力 - 使用

DirectByteBuf减少Sidecar间的内存拷贝

三、Serverless场景下的特殊优化

3.1 冷启动优化方案

| 优化手段 | 实施方法 | 效果评估 |

|---|---|---|

| 预热连接池 | 初始化时建立最小连接数 | 降低首次请求延迟30%-50% |

| 延迟加载Handler | 使用LazyInitializationHandler包装 | 减少内存占用20% |

| 镜像瘦身 | 使用Alpine基础镜像+模块化依赖 | 镜像体积减少60% |

示例连接池预热代码:

public class ConnectionPoolWarmer {

private final Bootstrap bootstrap;

private final int minConnections;

public void warmUp() {

List<ChannelFuture> futures = new ArrayList<>();

for (int i = 0; i < minConnections; i++) {

futures.add(bootstrap.connect());

}

futures.forEach(f -> {

try {

f.await();

if (!f.isSuccess()) {

logger.warn("Pre-warm connection failed", f.cause());

}

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

}

}3.2 连接池管理策略

Serverless环境需要动态调整连接池大小:

public class ElasticConnectionPool {

private final AtomicInteger activeConnections = new AtomicInteger();

private final int maxConnections;

public Channel getConnection() {

if (activeConnections.get() >= maxConnections) {

throw new IllegalStateException("Connection limit reached");

}

activeConnections.incrementAndGet();

return bootstrap.connect()

.addListener(f -> {

if (!f.isSuccess()) {

activeConnections.decrementAndGet();

}

}).channel();

}

public void releaseConnection(Channel ch) {

ch.close().addListener(f ->

activeConnections.decrementAndGet()

);

}

}最佳实践:

- 根据函数并发度自动缩放连接池

- 实现

ConnectionPoolMetrics对接云平台监控 - 采用

LRU策略淘汰长期闲置连接

四、性能对比数据

在AWS Lambda上的基准测试结果(1000次调用):

| 优化项 | 平均延迟 | P99延迟 | 内存消耗 |

|---|---|---|---|

| 未优化 | 320ms | 850ms | 256MB |

| 连接池预热 | 210ms | 410ms | 275MB |

| +延迟加载 | 205ms | 400ms | 210MB |

| +精简镜像 | 200ms | 390ms | 190MB |

五、故障排查指南

常见问题及解决方案:

Sidecar连接拒绝:

- 检查

appProtocol字段是否声明为tcp - 验证Netty版本与Envoy的兼容性

- 检查

健康检查失败:

# 诊断命令 kubectl describe pod/netty-app | grep -A 10 Events kubectl logs netty-app -c netty-container --tail=100内存泄漏定位:

// 启动参数添加泄漏检测 -Dio.netty.leakDetection.level=PARANOID

云原生适配检查清单:

- [ ] 服务发现集成

- [ ] 健康检查端点

- [ ] 资源限制配置

- [ ] 分布式追踪埋点

- [ ] 动态配置加载

通过以上方案,Netty应用可以充分发挥云原生架构的弹性优势,同时保持其高性能特性。实际部署时建议结合具体云平台特性进行针对性调优。

评论已关闭