Redis高可用架构解析:主从复制、哨兵与集群模式

Redis高可用与集群架构深度解析

Redis作为高性能的内存数据库,其高可用与集群方案是生产环境中的关键考量。本文将深入剖析Redis的三种核心高可用方案:主从复制、哨兵模式和集群模式。

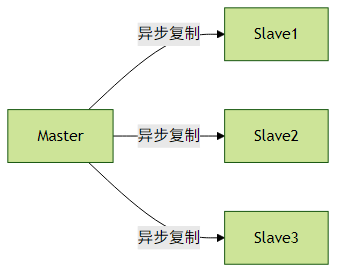

一、主从复制:数据冗余的基础

核心机制

主从复制是Redis最基础的高可用方案,采用异步复制机制:

工作流程:

- 从节点执行

SLAVEOF命令建立复制关系 - 主节点执行BGSAVE生成RDB文件并发送给从节点

- 从节点加载RDB完成全量同步

- 之后通过复制缓冲区进行增量同步

关键特性

- 异步复制:主节点写入后立即返回,不等待从节点确认

- 读写分离:主节点写,从节点读(需客户端支持)

- 数据冗余:多个从节点保障数据安全

实践建议

// Jedis配置读写分离示例

JedisPoolConfig poolConfig = new JedisPoolConfig();

JedisPool masterPool = new JedisPool(poolConfig, "master-host", 6379);

JedisPool slavePool = new JedisPool(poolConfig, "slave-host", 6379);

// 写操作

try (Jedis jedis = masterPool.getResource()) {

jedis.set("key", "value");

}

// 读操作

try (Jedis jedis = slavePool.getResource()) {

String value = jedis.get("key");

}注意事项:

- 网络延迟可能导致从节点数据短暂不一致

- 从节点过多会增加主节点网络负载

- 建议至少部署2个从节点保证冗余

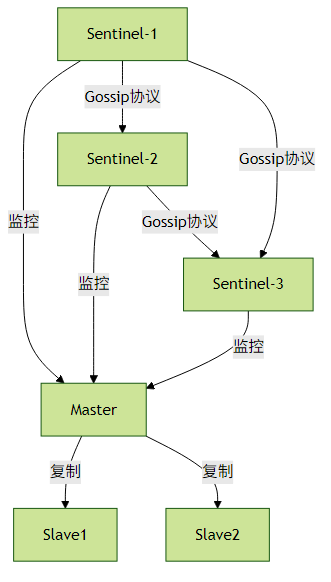

二、哨兵模式:自动故障转移

架构组成

核心功能

- 监控:持续检查主从节点状态

- 通知:通过API向管理员报告异常

自动故障转移:

- 主观下线(SDOWN):单个Sentinel判定节点不可用

- 客观下线(ODOWN):多数Sentinel达成共识

- 选举Leader Sentinel执行故障转移

配置示例

# sentinel.conf

sentinel monitor mymaster 127.0.0.1 6379 2

sentinel down-after-milliseconds mymaster 5000

sentinel failover-timeout mymaster 60000

sentinel parallel-syncs mymaster 1实践建议

- Sentinel节点数应为奇数(至少3个)

- 部署在不同物理机上避免单点故障

- 合理设置

down-after-milliseconds(通常5-30秒) - 客户端应实现Sentinel自动发现机制

Java客户端示例:

JedisSentinelPool sentinelPool = new JedisSentinelPool(

"mymaster",

new HashSet<>(Arrays.asList("sentinel1:26379", "sentinel2:26379")),

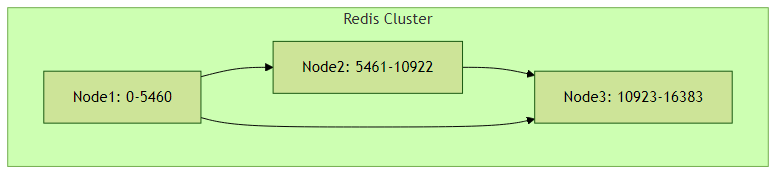

poolConfig);三、集群模式:分布式解决方案

数据分片架构

核心特性

- 数据分片:16384个哈希槽(slot)均匀分布

- Gossip协议:节点间PING/PONG通信

故障转移:

- 主节点故障时从节点自动升级

- 半数以上主节点存活时集群可用

集群操作示例

# 创建集群

redis-cli --cluster create \

127.0.0.1:7000 127.0.0.1:7001 \

127.0.0.1:7002 127.0.0.1:7003 \

127.0.0.1:7004 127.0.0.1:7005 \

--cluster-replicas 1

# 集群状态检查

redis-cli --cluster check 127.0.0.1:7000客户端路由策略

// Lettuce集群连接示例

RedisURI uri = RedisURI.create("redis://127.0.0.1:7000");

RedisClusterClient clusterClient = RedisClusterClient.create(uri);

StatefulRedisClusterConnection<String, String> connection = clusterClient.connect();

RedisAdvancedClusterCommands<String, String> commands = connection.sync();

commands.set("key", "value"); // 自动路由到正确节点实践建议

- 每个分片至少配置1个从节点

- 集群节点数不少于6个(3主3从)

- 避免大Key导致数据分布不均

- 使用

CLUSTER KEYSLOT命令调试数据分布

性能调优参数:

cluster-node-timeout 15000 # 节点超时时间

cluster-migration-barrier 1 # 主节点最少从节点数

cluster-require-full-coverage no # 部分故障时是否停止服务四、方案选型指南

| 特性 | 主从复制 | 哨兵模式 | 集群模式 |

|---|---|---|---|

| 数据规模 | <10GB | <50GB | >50GB |

| 可用性 | 手动故障转移 | 自动故障转移 | 自动故障转移 |

| 扩展性 | 垂直扩展 | 垂直扩展 | 水平扩展 |

| 读写吞吐量 | 10万QPS以下 | 10万QPS以下 | 百万级QPS |

| 适用场景 | 数据备份 | 高可用中小规模系统 | 大规模分布式系统 |

五、常见问题解决方案

脑裂问题:

- 设置

min-slaves-to-write和min-slaves-max-lag - 哨兵模式下合理配置quorum值

- 设置

复制延迟:

- 监控

master_repl_offset与slave_repl_offset差值 - 避免主节点写入峰值

- 监控

集群扩容:

redis-cli --cluster add-node \ 新节点IP:端口 已存在节点IP:端口 \ --cluster-slave --cluster-master-id 主节点ID跨机房部署:

- 使用

cluster-announce-ip暴露公网IP - 调整

cluster-announce-port和cluster-announce-bus-port

- 使用

通过合理选择和配置Redis的高可用方案,可以构建出满足不同业务场景需求的稳定架构。生产环境中建议结合监控系统(如Prometheus+Granfa)实时掌握集群状态。