Redis多语言客户端集成与连接池优化指南

Redis多语言客户端与中间件集成实战指南

一、多语言客户端实现差异

1.1 连接池实现对比

不同语言的Redis客户端在连接池实现上存在显著差异:

Java客户端(以Jedis为例):

JedisPoolConfig poolConfig = new JedisPoolConfig();

poolConfig.setMaxTotal(128); // 最大连接数

poolConfig.setMaxIdle(32); // 最大空闲连接

poolConfig.setMinIdle(8); // 最小空闲连接

JedisPool jedisPool = new JedisPool(poolConfig, "localhost", 6379);

try (Jedis jedis = jedisPool.getResource()) {

jedis.set("foo", "bar");

String value = jedis.get("foo");

}Python客户端(redis-py):

import redis

pool = redis.ConnectionPool(

host='localhost',

port=6379,

max_connections=100,

decode_responses=True

)

r = redis.Redis(connection_pool=pool)

r.set('foo', 'bar')

print(r.get('foo'))Go客户端(go-redis):

import "github.com/go-redis/redis/v8"

client := redis.NewClient(&redis.Options{

Addr: "localhost:6379",

PoolSize: 100, // 连接池大小

MinIdleConns: 10, // 最小空闲连接

})

ctx := context.Background()

err := client.Set(ctx, "foo", "bar", 0).Err()

if err != nil {

panic(err)

}

val, err := client.Get(ctx, "foo").Result()关键差异对比:

| 特性 | Java(Jedis) | Python(redis-py) | Go(go-redis) |

|---|---|---|---|

| 连接池实现 | Apache Commons Pool | 内置简单连接池 | 内置高效连接池 |

| 线程安全 | 连接非线程安全 | 客户端线程安全 | 客户端线程安全 |

| 连接泄漏检测 | 支持 | 不支持 | 支持 |

| 异步支持 | 需Lettuce | 支持 | 原生支持 |

1.2 协议兼容性注意事项

Redis使用RESP(Redis Serialization Protocol)协议,但不同客户端对协议特性的支持程度不同:

批量命令处理:

- 部分客户端对Pipeline和事务的支持存在差异

- Go客户端默认开启Pipeline优化

数据类型映射:

# Python中HGETALL返回字典 user = r.hgetall("user:1000") # {'name': 'Alice', 'age': '30'} // Java中返回List<String> Map<String, String> user = jedis.hgetAll("user:1000");Lua脚本支持:

- 各客户端对Lua脚本返回值处理方式不同

- 复杂返回值建议统一转为JSON格式

实践建议:

- 生产环境建议配置连接池健康检查

- 跨语言项目应统一序列化格式(推荐JSON或MessagePack)

- 使用

CLIENT LIST命令监控连接状态

二、与中间件协作模式

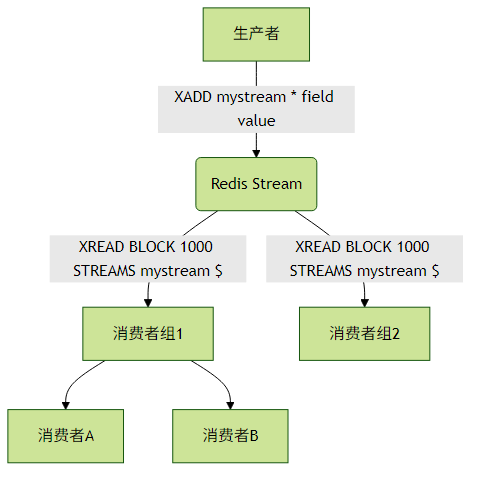

2.1 Redis Streams vs 传统消息队列

Redis 5.0引入的Streams类型提供了完整的消息队列功能:

与Kafka/RabbitMQ对比:

| 特性 | Redis Streams | Kafka | RabbitMQ |

|---|---|---|---|

| 消息持久化 | 可配置 | 持久化 | 持久化/内存 |

| 消费组 | 支持 | 支持 | 不支持 |

| 消息回溯 | 支持 | 支持 | 不支持 |

| 吞吐量 | 10万+/秒 | 百万+/秒 | 5万+/秒 |

| 延迟 | 亚毫秒级 | 毫秒级 | 微秒级 |

典型应用场景:

- Redis Streams:实时性要求高、数据量适中的场景(如用户行为追踪)

- Kafka:大数据量、高吞吐场景(如日志收集)

- RabbitMQ:需要复杂路由、可靠投递的场景(如订单系统)

2.2 缓存与数据库一致性方案

双写模式问题示例:

// 问题代码:非原子性双写

public void updateUser(User user) {

// 先写数据库

userDao.update(user);

// 再删缓存

redis.del("user:" + user.getId());

}解决方案1:Cache Aside Pattern

public User getUser(long id) {

// 1. 先查缓存

User user = redis.get("user:" + id);

if (user != null) {

return user;

}

// 2. 查数据库

user = userDao.get(id);

if (user != null) {

// 3. 写入缓存

redis.setex("user:" + id, 3600, user);

}

return user;

}

public void updateUser(User user) {

// 1. 更新数据库

userDao.update(user);

// 2. 删除缓存

redis.del("user:" + user.getId());

}解决方案2:延时双删

public void updateUser(User user) {

// 1. 先删缓存

redis.del("user:" + user.getId());

// 2. 更新数据库

userDao.update(user);

// 3. 延时再删(异步执行)

asyncTask.execute(() -> {

Thread.sleep(500);

redis.del("user:" + user.getId());

});

}实践建议:

- 读多写少场景使用Cache Aside

- 写多场景考虑使用Write Behind模式

- 强一致性要求场景结合分布式锁实现

三、最佳实践总结

客户端选择:

- Java高并发场景推荐Lettuce而非Jedis

- Python异步项目使用aioredis

- Go项目优先选择go-redis

中间件协作:

- 消息积压超过1万条考虑迁移到Kafka

- 使用Redis Streams时合理设置

MAXLEN防止内存溢出

一致性保障:

- 为缓存设置合理的过期时间(即使不一致也能自动恢复)

- 使用canal监听数据库binlog同步更新缓存

监控指标:

# 监控缓存命中率 redis-cli info stats | grep keyspace_hits redis-cli info stats | grep keyspace_misses # 监控Streams积压 redis-cli xlen mystream

通过合理选择客户端实现和中间件协作模式,Redis可以成为分布式系统中高效的数据枢纽节点。